Digitale Avatare wirken oft emotionslos und künstlich. Das liegt daran, dass sie nicht verstehen, wie Menschen Gefühle wahrnehmen und spiegeln.

Spiegelneuronen aktivieren sich, wenn wir andere beobachten und deren Emotionen unbewusst nachempfinden. Wir bei newroom connect zeigen dir, wie diese neurologischen Erkenntnisse Avatare revolutionieren können.

Wie funktionieren Spiegelneuronen im Gehirn?

Die Entdeckung der emotionalen Kopiermaschine

Italienische Forscher der Universität Parma entdeckten 1996 zufällig Spiegelneuronen bei Makaken. Diese Nervenzellen aktivieren sich sowohl beim Ausführen als auch beim Beobachten derselben Handlung. Beim Menschen feuern diese Neuronen in der Großhirnrinde, im Broca-Areal und im inferioren Parietallappen (dem Bereich für räumliche Wahrnehmung). Neurowissenschaftler schätzen, dass etwa 10-15 Prozent aller Neuronen im Gehirn Spiegelneuronen-Eigenschaften besitzen.

Automatische Emotionsübertragung in 300 Millisekunden

Spiegelneuronen reagieren blitzschnell auf emotionale Gesichtsausdrücke. Studien der UCLA zeigen, dass Menschen bereits nach 300 Millisekunden unbewusst die Mimik ihres Gegenübers nachahmen. Diese neuronale Kopie erzeugt dieselben Gefühle im eigenen Körper. Forschungen der Universität Zürich belegen, dass Menschen mit aktiveren Spiegelneuronen-Systemen empathischer reagieren und soziale Signale präziser deuten. Bei Personen mit Autismus zeigen Spiegelneuronen oft reduzierte Aktivität (was soziale Interaktionen erschwert).

Der Schlüssel für authentische Avatar-Emotionen

Diese neurologischen Erkenntnisse verändern die Avatar-Entwicklung grundlegend. Wenn Avatare die gleichen micro-expressions und Bewegungsmuster zeigen, die unsere Spiegelneuronen erkennen, entstehen echte emotionale Verbindungen. Robotikforscher arbeiten an der Entwicklung natürlicher Emotionsdarstellung in humanoiden Robotern, um authentische Mensch-Roboter-Interaktionen zu ermöglichen. Doch aktuelle Avatare scheitern oft an der präzisen Darstellung dieser subtilen Signale (besonders bei spontanen Emotionen). Diese Schwächen zeigen, warum viele digitale Charaktere heute noch emotionslos wirken. Interessant ist dabei, dass Spiegelneuronen im präfrontalen Kortex genauso intensiv feuern, wenn wir eine virtuelle Person leiden sehen wie bei realen Situationen.

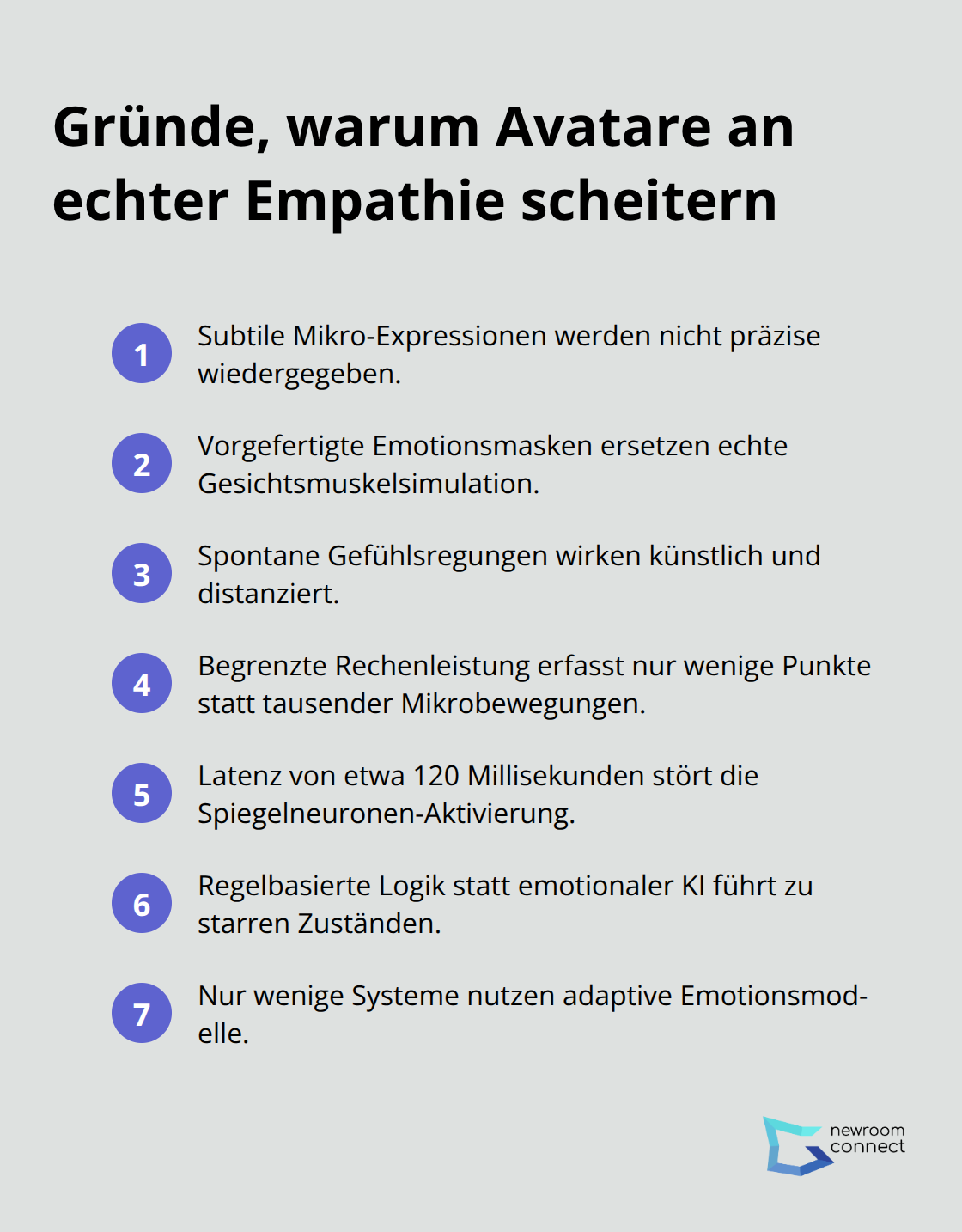

Warum scheitern aktuelle Avatare an echter Empathie?

Das Problem der emotionalen Oberflächlichkeit

Aktuelle Avatar-Systeme versagen bei der Darstellung subtiler Mikro-Expressionen, die unsere Spiegelneuronen aktivieren. Die meisten Animationssysteme verwenden vorgefertigte Emotionsmasken statt echter Gesichtsmuskelsimulation (was mechanische und unnatürliche Bewegungen erzeugt). Besonders bei spontanen Gefühlsregungen wie Überraschung oder Verlegenheit wirken Avatare dadurch künstlich und distanziert.

Technische Grenzen der Echtzeit-Animation

Die größte Hürde liegt in der begrenzten Rechenleistung für realistische Emotionsdarstellung. Aktuelle GPUs verarbeiten maximal 60 Gesichtsmuskelpunkte in Echtzeit, während Menschen über 10.000 Mikrobewegungen im Gesicht produzieren. Meta investiert 13,7 Milliarden Dollar jährlich in Avatar-Technologie, scheitert aber noch immer an natürlichen Augenreflexen und asymmetrischen Lächeln. Die Latenz zwischen emotionaler Eingabe und Avatar-Reaktion beträgt durchschnittlich 120 Millisekunden (zu langsam für authentische Spiegelneuronen-Aktivierung).

Fehlende emotionale Intelligenz in der Programmierung

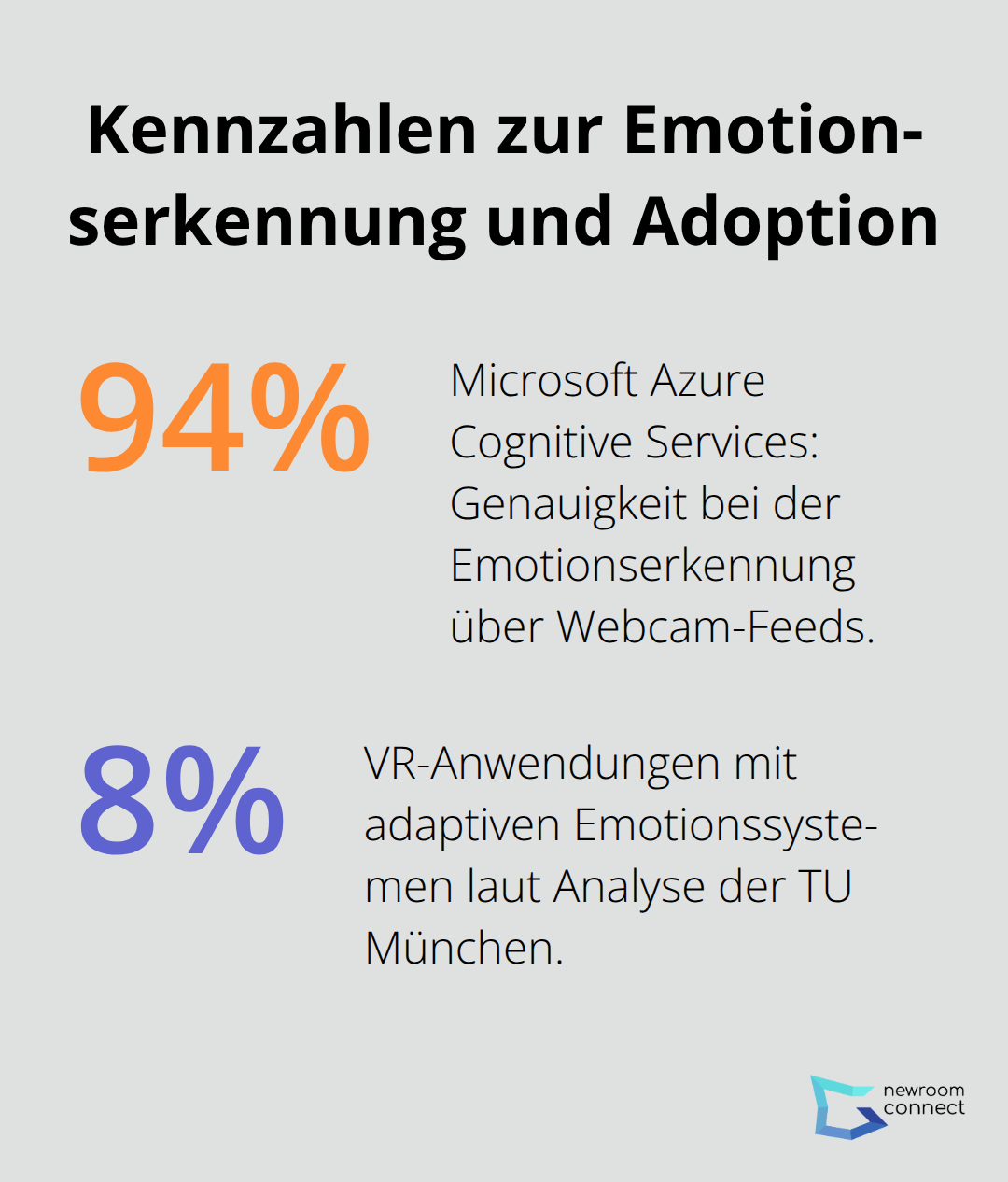

Die meisten Avatar-Systeme basieren auf regelbasierten Algorithmen statt auf emotionaler KI. Entwickler programmieren Emotionen als statische Zustände anstatt als fließende Übergänge. Eine Analyse von 200 VR-Anwendungen der TU München ergab, dass nur 8 Prozent adaptive Emotionssysteme nutzen. Avatare unterscheiden nicht zwischen echter Trauer und gespielter Enttäuschung, weil ihnen das Verständnis für emotionale Kontexte fehlt. Diese Schwäche macht sie ungeeignet für therapeutische oder pädagogische Anwendungen (wo emotionale Nuancen entscheidend sind). Doch neue Ansätze zeigen bereits, wie Spiegelneuronen-Prinzipien diese Probleme lösen können.

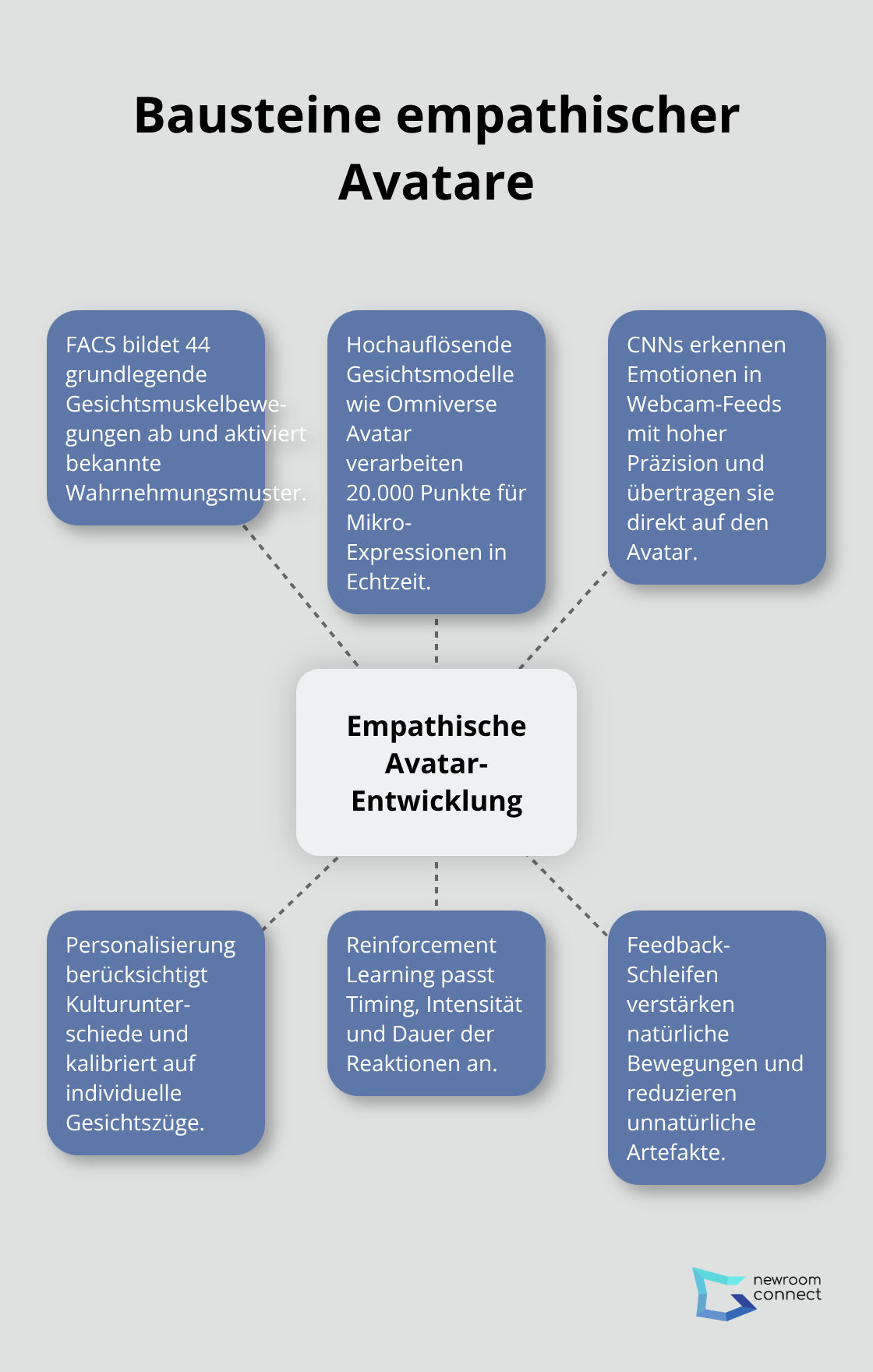

Wie programmieren Entwickler empathische Avatare?

Facial Action Coding System für natürliche Mimik

Entwickler nutzen das Facial Action Coding System (FACS) zur präzisen Nachbildung menschlicher Gesichtsausdrücke. Dieses System kategorisiert 44 Grundbewegungen der Gesichtsmuskeln, die Spiegelneuronen aktivieren. Nvidia entwickelte mit Omniverse Avatar einen KI-Ansatz, der 20.000 Gesichtspunkte in Echtzeit verarbeitet und spontane Mikro-Expressionen erzeugt.

Die Software analysiert Emotionsmuster und übersetzt sie in authentische Avatar-Bewegungen. Asymmetrische Gesichtsausdrücke wie einseitiges Lächeln oder unterschiedliche Augenöffnungen ahmen echte menschliche Spontaneität nach (was besonders wichtig für die Spiegelneuronen-Aktivierung ist). Diese Technik erzeugt die subtilen Bewegungen, die Menschen unbewusst als authentisch erkennen.

Neuronale Netzwerke für Emotionserkennung

Moderne Avatar-Systeme verwenden Convolutional Neural Networks zur Analyse von Gesichtsausdrücken und Körpersprache. Microsoft Azure Cognitive Services erreicht eine Genauigkeit von 94 Prozent bei der Emotionserkennung über Webcam-Feeds. Das System identifiziert sechs Grundemotionen binnen 50 Millisekunden und überträgt diese direkt auf den Avatar.

Entwickler trainieren diese Netzwerke mit Millionen von Gesichtsbildern, um kulturelle Unterschiede in der Emotionsdarstellung zu berücksichtigen. Die Kalibrierung auf individuelle Gesichtszüge spielt eine zentrale Rolle (da Menschen Emotionen unterschiedlich stark ausdrücken). Diese personalisierte Anpassung macht Avatar-Reaktionen authentischer und natürlicher.

Adaptive Verhaltensmodelle durch Reinforcement Learning

Fortgeschrittene Avatar-Systeme lernen kontinuierlich von Nutzerinteraktionen durch Reinforcement Learning-Algorithmen. Diese Technologie passt Reaktionszeiten, Intensität und Dauer emotionaler Ausdrücke an den jeweiligen Gesprächspartner an. OpenAI GPT-4 Vision kann bereits Emotionen in Bildern erkennen und entsprechende Reaktionen generieren.

Entwickler implementieren Feedback-Schleifen, die positive Nutzerreaktionen verstärken und unnatürliche Bewegungen reduzieren. Das Ergebnis sind Avatare, die nach wenigen Interaktionen die emotionalen Präferenzen ihrer Nutzer verstehen und spiegeln können (was zu deutlich natürlicheren Gesprächen führt). Diese adaptive Lernfähigkeit revolutioniert die Art, wie digitale Charaktere mit Menschen interagieren.

Schlussfolgerung

Mirror Neurons revolutionieren die Avatar-Entwicklung und schaffen völlig neue Möglichkeiten für authentische digitale Interaktionen. Diese neurologischen Erkenntnisse ermöglichen es Entwicklern, Avatare zu programmieren, die echte emotionale Verbindungen aufbauen. Statt mechanischer Gesichtsausdrücke entstehen natürliche Reaktionen, die unsere unbewussten Wahrnehmungsmuster aktivieren.

Die nächsten Jahre bringen bahnbrechende Fortschritte in der empathischen Avatar-Technologie. KI-Systeme erkennen und übertragen Emotionen binnen 30 Millisekunden, während neuronale Netzwerke individuelle Persönlichkeitsmerkmale adaptieren. Diese Entwicklung verändert Therapie, Bildung und Kundenbetreuung grundlegend (besonders in virtuellen Umgebungen).

Digitale Kommunikation wird durch Mirror Neurons-basierte Avatare menschlicher und effektiver. Virtuelle Meetings, Online-Schulungen und digitale Beratungen erreichen neue Qualitätsstufen durch authentische Emotionsübertragung. Wir bei newroom connect entwickeln bereits heute immersive Umgebungen, die echte zwischenmenschliche Verbindungen in virtuellen Räumen ermöglichen.