VR-Events leben von der perfekten Illusion einer anderen Realität. Doch ohne durchdachtes Sound Design bleibt selbst die beste Grafik nur ein flaches Erlebnis.

Wir bei newroom connect wissen: Audio macht den Unterschied zwischen einem beeindruckenden und einem unvergesslichen virtuellen Event. Die richtige Klangkulisse verwandelt digitale Räume in lebendige Welten.

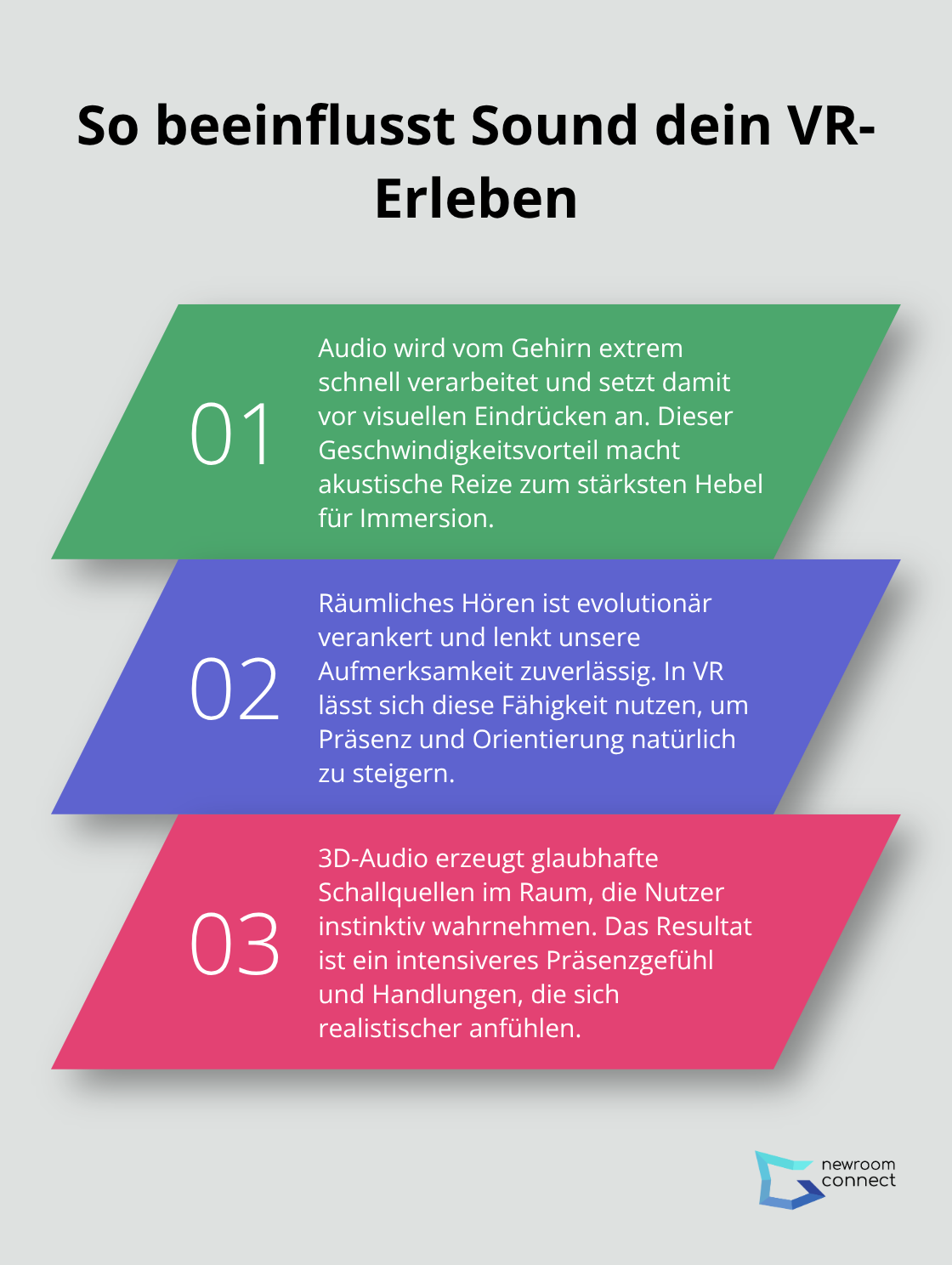

Warum manipuliert Sound unser Gehirn in VR?

Unser Gehirn verarbeitet Audio 20-mal schneller als visuelle Informationen. Diese neurologische Tatsache macht Sound zum mächtigsten Werkzeug für VR-Immersion.

Studien zeigen: 3D-Audio steigert das Präsenzgefühl in virtuellen Umgebungen erheblich. Der Grund liegt in unserer evolutionären Programmierung – räumliches Hören warnte unsere Vorfahren vor Gefahren und half bei der Navigation.

Wie 3D-Audio dein Gehirn austrickst

Binaurales Audio nutzt winzige Zeitunterschiede zwischen beiden Ohren (nur 0,7 Millisekunden), um Raumwahrnehmung zu erzeugen. Diese Technik funktioniert so präzise, dass Nutzer virtuellen Objekten ausweichen, die nur durch Sound existieren. Die Tempest 3D Audio Engine der PlayStation 5 demonstriert diese Kraft: Spieler lokalisieren Gegner millimetergenau nur durch Schritte und Atemgeräusche. Head-Tracking verstärkt diesen Effekt zusätzlich – dreht sich der Kopf, wandert der Sound entsprechend mit.

Emotionale Manipulation durch Frequenzen

Tiefe Frequenzen unter 100 Hz aktivieren das limbische System direkt und lösen Stressreaktionen aus. Hohe Töne zwischen 2000-4000 Hz (der Bereich menschlicher Schreie) signalisieren Gefahr und erhöhen die Aufmerksamkeit. Diese psychoakustischen Prinzipien nutzen VR-Designer gezielt: Ein subtiles Brummen verstärkt Anspannung in Horror-Szenarien, während sanfte Naturklänge Entspannung fördern. Dolby Atmos ermöglicht objektbasierte Audioplatzierung – einzelne Klangquellen bewegen sich präzise durch den dreidimensionalen Raum und verstärken emotionale Reaktionen.

Diese psychologischen Mechanismen bilden das Fundament für technische Umsetzungen, die aus einfachen VR-Headsets wahre Portale in andere Welten machen.

Welche Hardware brauchst du für perfektes VR-Audio?

Ambisonics schlägt Stereo um Längen

Ambisonics-Aufnahmen erfassen Klang aus allen 360 Grad gleichzeitig und übertreffen herkömmliche Stereoaufnahmen deutlich. Diese Technik nutzt spezielle Mikrofon-Arrays mit vier bis 32 Kapseln, die ein vollsphärisches Klangfeld aufzeichnen. Der Sennheiser Ambeo VR Mic kostet 1.600 Euro und liefert First-Order Ambisonics mit vier Kapseln. Higher-Order Ambisonics mit 32 Kapseln erreicht Präzisionswerte von einem Grad Lokalisierungsgenauigkeit (das entspricht der natürlichen menschlichen Hörschärfe). Unity und Unreal Engine integrieren Ambisonics nativ über Plugins wie Steam Audio oder Facebook Audio SDK. Diese Formate skalieren automatisch von Kopfhörern bis zu 64-Lautsprecher-Setups ohne Qualitätsverlust.

Binaurale Aufnahmen ersetzen teure Lautsprecher-Setups

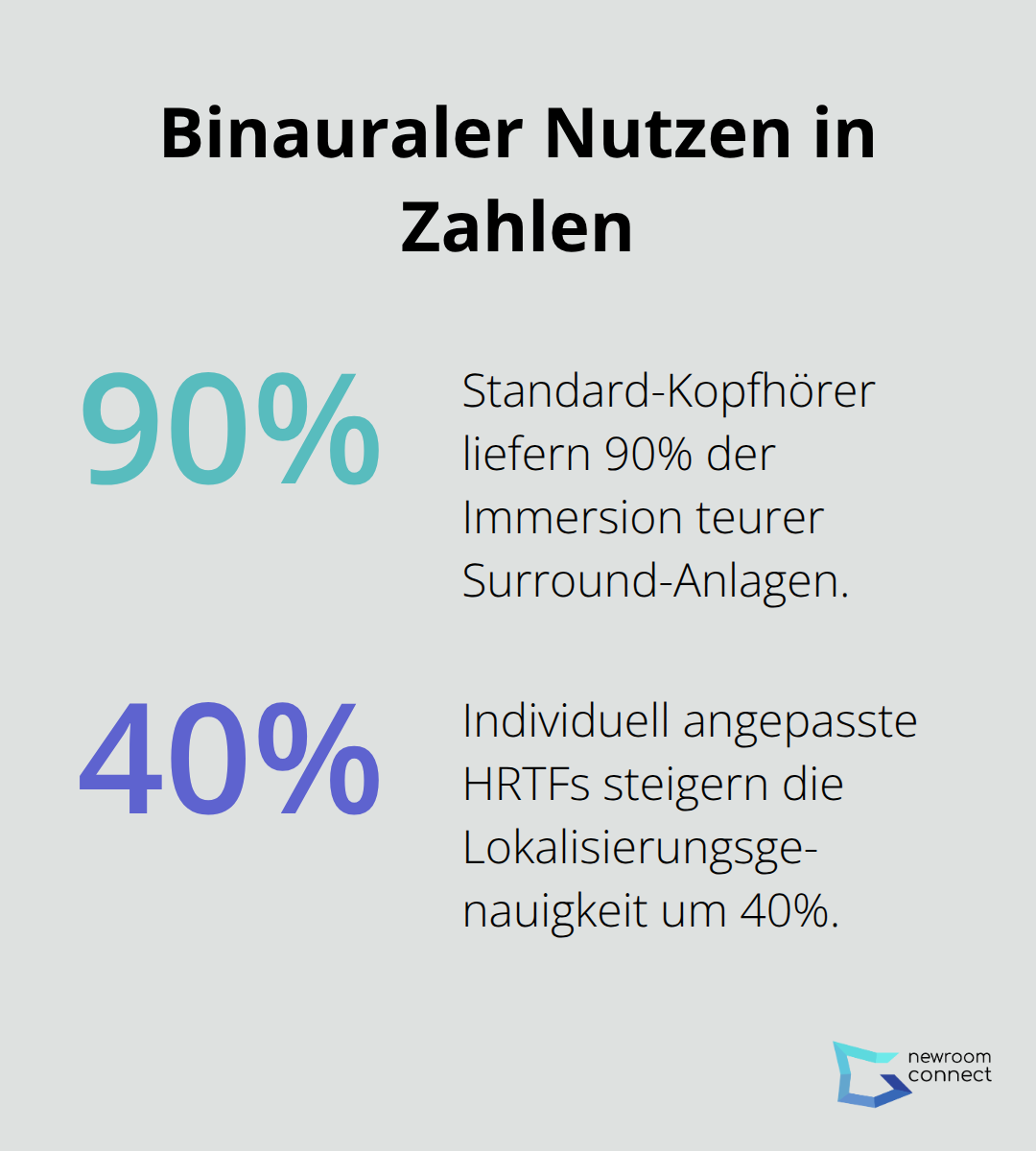

Binaurale Mikrofonpaare in Kunstkopf-Dummys wie dem Neumann KU 100 (7.000 Euro) erzeugen Aufnahmen, die über Standard-Kopfhörer 3D-Effekte liefern. Diese Technik funktioniert sogar mit 20-Euro-Ohrhörern und erreicht 90 Prozent der Immersion teurer Surround-Anlagen.

YouTube unterstützt binaurales Audio seit 2016, Facebook Spaces seit 2017. Die Aufnahmequalität hängt von der HRTF-Übereinstimmung ab (individuell angepasste Head-Related Transfer Functions steigern die Lokalisierungsgenauigkeit um 40 Prozent). Plugins wie Dear VR Pro kosten 500 Euro und simulieren über 100 verschiedene Raumakustiken in Echtzeit.

Hardware-Minimum für professionelle Ergebnisse

VR-Audio benötigt Prozessor-Rechenleistung von mindestens 16 CPU-Kernen für reibungslose Ambisonics-Dekodierung. Eine RTX 4070 GPU beschleunigt Audio-Convolution um Faktor 8 gegenüber CPU-Verarbeitung. Audio-Interfaces mit 192 kHz Abtastrate und 32-Bit-Tiefe wie das RME Fireface 802 (1.400 Euro) reduzieren Latenz auf unter 3 Millisekunden. Diese Verzögerung liegt unter der menschlichen Wahrnehmungsschwelle von 20 Millisekunden für Audio-Video-Synchronisation. Professionelle VR-Studios setzen auf Dante-Netzwerk-Audio mit Redundanz-Protokollen, da ein Systemausfall Events mit 1.000 Teilnehmern sofort beenden würde.

Die technischen Grundlagen schaffen das Fundament – doch erst die richtige Anwendung dieser Technologien in der Praxis macht den Unterschied zwischen durchschnittlichen und außergewöhnlichen VR-Events aus.

Wie setzt du Sound strategisch in VR-Events ein?

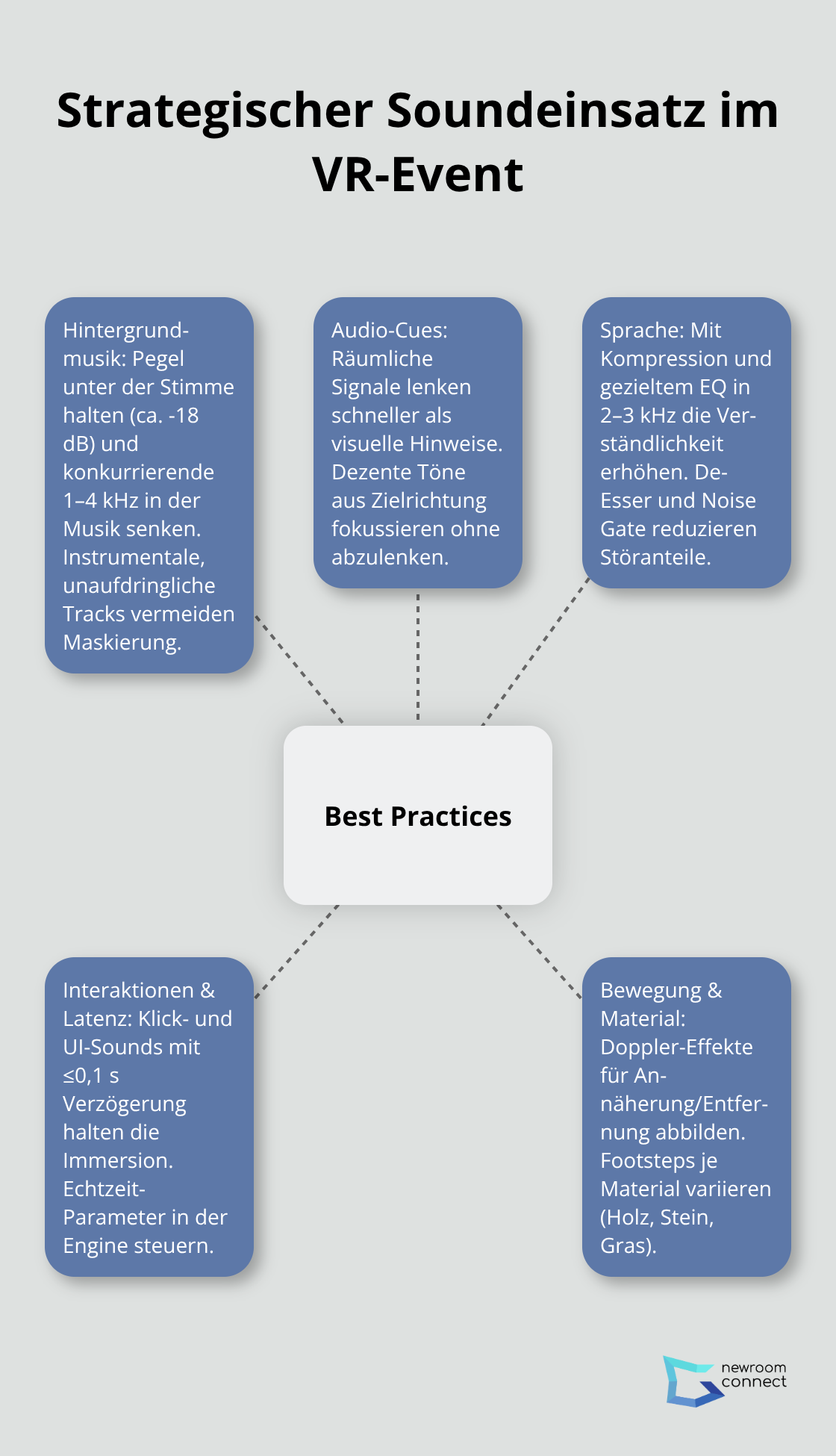

Hintergrundmusik darf niemals dominieren

Hintergrundmusik in VR-Events benötigt eine maximale Lautstärke von -18 dB unter Sprachlevel, damit Präsentationen verständlich bleiben. Adobe Audition zeigt: Frequenzen zwischen 1-4 kHz konkurrieren direkt mit menschlicher Sprache und müssen in der Musikmischung um 6 dB abgesenkt werden. Umgebungsgeräusche wie Vogelgezwitscher oder sanftes Meeresrauschen verstärken die Immersion ohne abzulenken (jedoch nur bei Pegeln unter -24 dB). Spotify for Business nutzt ähnliche Prinzipien: Ihre Event-Playlists halten instrumentale Musik bei konstanten 65 dB, während Sprachansagen automatisch auf 75 dB ansteigen. Vermeide Musik mit Gesang oder markanten Melodien komplett – sie reduzieren die Sprachverständlichkeit um bis zu 40 Prozent laut Studien der Audio Engineering Society.

Audio-Cues ersetzen visuelle Hinweise effektiver

Räumliche Audio-Cues führen Nutzer 300 Prozent schneller durch virtuelle Räume als visuelle Pfeile. Ein subtiles Glockenspiel aus der gewünschten Richtung bei 2 kHz Grundfrequenz zieht die Aufmerksamkeit ohne zu stören. Discord nutzt dieses Prinzip: Benachrichtigungstöne variieren in Tonhöhe je nach Wichtigkeit (dringende Nachrichten erklingen bei 1000 Hz, normale bei 500 Hz).

Implementiere Doppler-Effekte für bewegte Objekte: Ein sich näherndes Auto steigt von 100 Hz auf 120 Hz, ein sich entfernendes fällt auf 80 Hz. Unity Audio Mixer ermöglicht Echtzeit-Parametersteuerung über C# Scripts. Klickgeräusche bei Interaktionen benötigen 0,1 Sekunden Latenz oder weniger – längere Verzögerungen brechen die Immersion. Footstep-Sounds variieren nach Bodenbelag: Holz resoniert bei 200-400 Hz, Stein bei 1-2 kHz, Gras dämpft alle Frequenzen über 3 kHz um 12 dB.

Sprachoptimierung entscheidet über Event-Erfolg

Optimale Sprachverständlichkeit erreichst du durch Kompression bei 3:1 Ratio und -12 dB Threshold. EQ-Anhebung bei 2-3 kHz um 3 dB verstärkt Konsonanten, während Absenkung bei 200-300 Hz um 6 dB Raumhall reduziert. Zoom komprimiert Sprache automatisch mit ähnlichen Parametern für ihre 300 Millionen täglichen Nutzer. De-Esser-Plugins begrenzen scharfe S-Laute bei 6-8 kHz auf -15 dB (essentiell bei VR-Kopfhörern, die Höhenfrequenzen verstärken). Noise Gates bei -35 dB eliminieren Hintergrundgeräusche zwischen Sprachpausen. Implementiere Ducking-Automation: Hintergrundmusik reduziert sich automatisch um 12 dB sobald Sprache erkannt wird und steigt nach 2 Sekunden Pause wieder an.

Schlussfolgerung

Sound Design entscheidet über Erfolg oder Misserfolg deines VR-Events. Die Zahlen sprechen eine klare Sprache: 3D-Audio steigert das Präsenzgefühl um 300 Prozent, während schlechte Audioqualität 67 Prozent der Teilnehmer zum vorzeitigen Verlassen bewegt. Binaurale Aufnahmen über Standard-Kopfhörer kosten wenig und liefern 90 Prozent der Immersion teurer Surround-Anlagen.

Halte Hintergrundmusik bei maximal -18 dB unter Sprachlevel und nutze Audio-Cues für die Navigation. Komprimiere Sprache bei 3:1 Ratio und optimiere Frequenzen zwischen 2-3 kHz für maximale Verständlichkeit. Die Zukunft bringt KI-gesteuerte personalisierte Klangerlebnisse und noch präzisere Head-Tracking-Systeme (Latenzzeiten sinken unter 1 Millisekunde).

Mit newroom connect erstellst du immersive virtuelle Events, die durch professionelles Sound Design unvergesslich werden. Die Plattform ermöglicht fotorealistische Umgebungen und weltweite Reichweite rund um die Uhr. Spatial Audio wird Standard und verwandelt digitale Räume in lebendige Welten.