Dein Puls steigt, deine Augen wandern, deine Haut reagiert – und die virtuelle Welt passt sich in Echtzeit an deine körperlichen Signale an.

Wir bei newroom connect beobachten, wie Bio-Feedback Events die Art revolutionieren, wie virtuelle Erlebnisse auf jeden Nutzer individuell eingehen. Statt starrer Inhalte entstehen adaptive Umgebungen, die auf deine Herzfrequenz, Augenbewegungen und Emotionen reagieren.

Diese Technologie macht virtuelle Welten nicht nur persönlicher, sondern auch effektiver für Training, Lernen und Unterhaltung.

Wie physiologische Daten virtuelle Erlebnisse revolutionieren

Herzfrequenz und Stresslevel als Anpassungsparameter

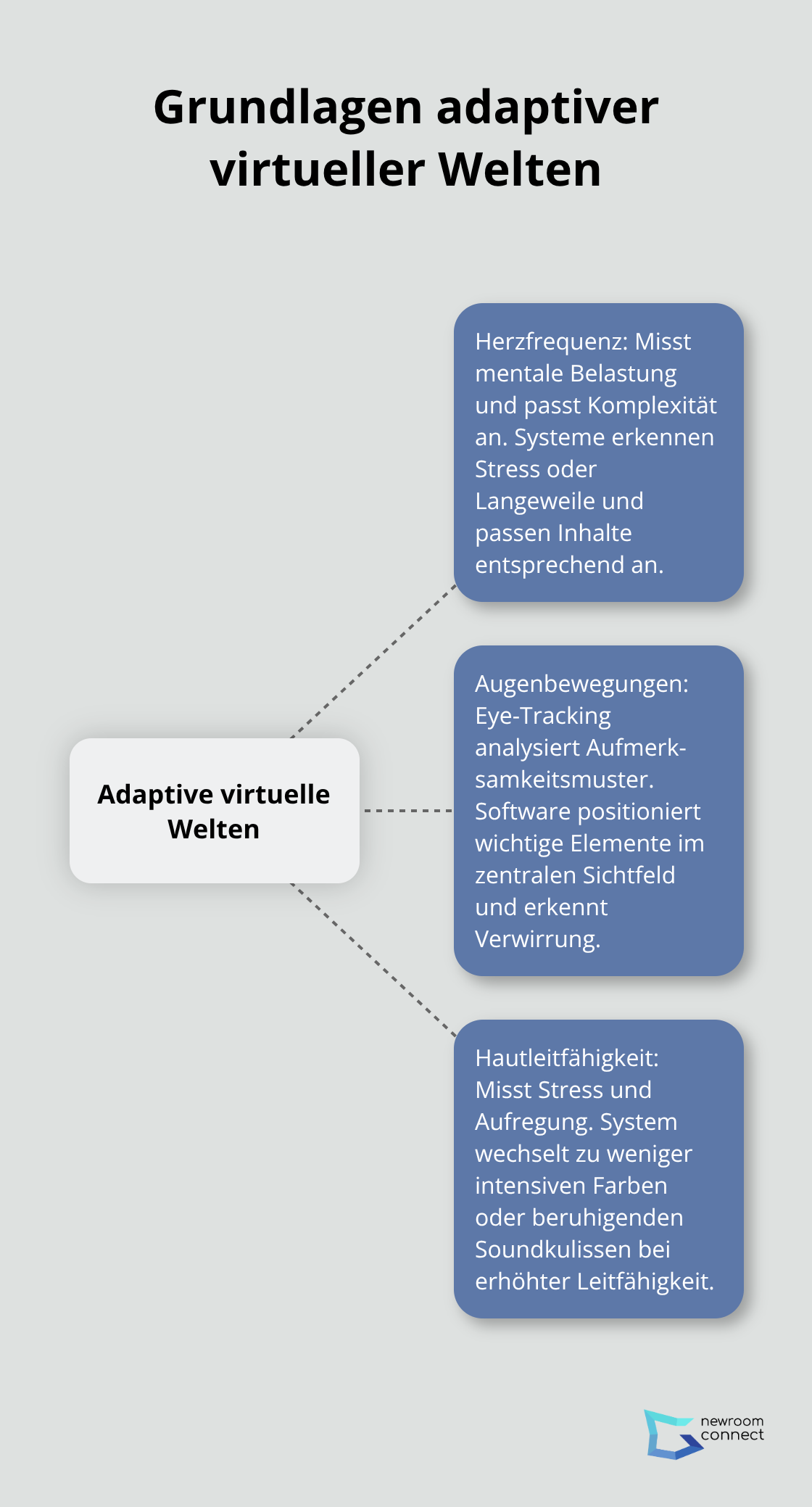

Dein Herzschlag reagiert binnen Sekunden auf virtuelle Inhalte und verrät präzise deine mentale Belastung. Moderne VR-Systeme integrieren Pulsmesser und EKG-Sensoren, die deine Herzratenvariabilität kontinuierlich überwachen. Steigt dein Puls über 120 Schläge pro Minute, passt die Software automatisch die Komplexität an oder wechselt zu beruhigenderen Szenarien.

Bei niedrigen Herzfrequenzen unter 60 Schlägen erkennt das System Langeweile und erhöht die Herausforderung durch zusätzliche interaktive Elemente. Diese Anpassungen erfolgen in Echtzeit und schaffen optimale Lernbedingungen für jeden Nutzer (ohne bewusste Eingaben zu erfordern).

Augenbewegungen für optimierte Benutzerführung

Deine Blickbewegungen enthüllen exakt, welche virtuellen Objekte dich fesseln und welche du übersiehst. Eye-Tracking-Kameras erfassen bis zu 1000 Blickpunkte pro Sekunde und analysieren deine Aufmerksamkeitsmuster. Verweilt dein Blick weniger als zwei Sekunden auf wichtigen Inhalten, repositioniert die Software diese Elemente automatisch in dein zentrales Sichtfeld.

Tobii Pro Spectrum und vergleichbare Geräte ermöglichen präzise Blickverfolgung und erkennen sogar Verwirrung durch unregelmäßige Blicksprünge. Das System reagiert durch vereinfachte Darstellungen oder zusätzliche visuelle Hinweise (die deine Navigation verbessern).

Hautleitfähigkeit zur Emotionserkennung

Deine Handflächen werden feucht, sobald virtuelle Situationen Stress oder Aufregung auslösen. Galvanische Hautwiderstandsmesser an Handgelenk oder Fingern registrieren diese Veränderungen binnen Millisekunden und messen mit einer Genauigkeit von 0,01 Mikrosiemens. Bei erhöhter Hautleitfähigkeit wechselt das System zu weniger intensiven Farben oder beruhigenden Soundkulissen.

Diese Technologie reagiert 200-mal schneller als bewusste Rückmeldungen und ermöglicht präzise Emotionserkennung. Virtuelle Umgebungen können dadurch ihre Atmosphäre dynamisch an deine emotionalen Bedürfnisse anpassen (bevor du selbst merkst, dass du gestresst bist).

Diese drei Biosignale bilden die Grundlage für adaptive virtuelle Welten, die sich nahtlos an jeden Nutzer anpassen. Biofeedback verwandelt deine Körpersignale in präzise Steuerungsdaten für personalisierte VR-Erlebnisse.

Praktische Anwendungen physiologischer Personalisierung

Adaptive VR-Trainingsumgebungen in der Medizin

Chirurgen trainieren komplexe Eingriffe in virtuellen Operationssälen, während Sensoren ihre Nervosität und Konzentration überwachen. Das VirtaMed-System misst kontinuierlich Herzfrequenz und Handzittern während laparoskopischen Simulationen. Steigt der Puls über 100 Schläge pro Minute, reduziert die Software automatisch die Komplexität oder pausiert für Entspannungsübungen (ohne den Trainingsfluss zu unterbrechen).

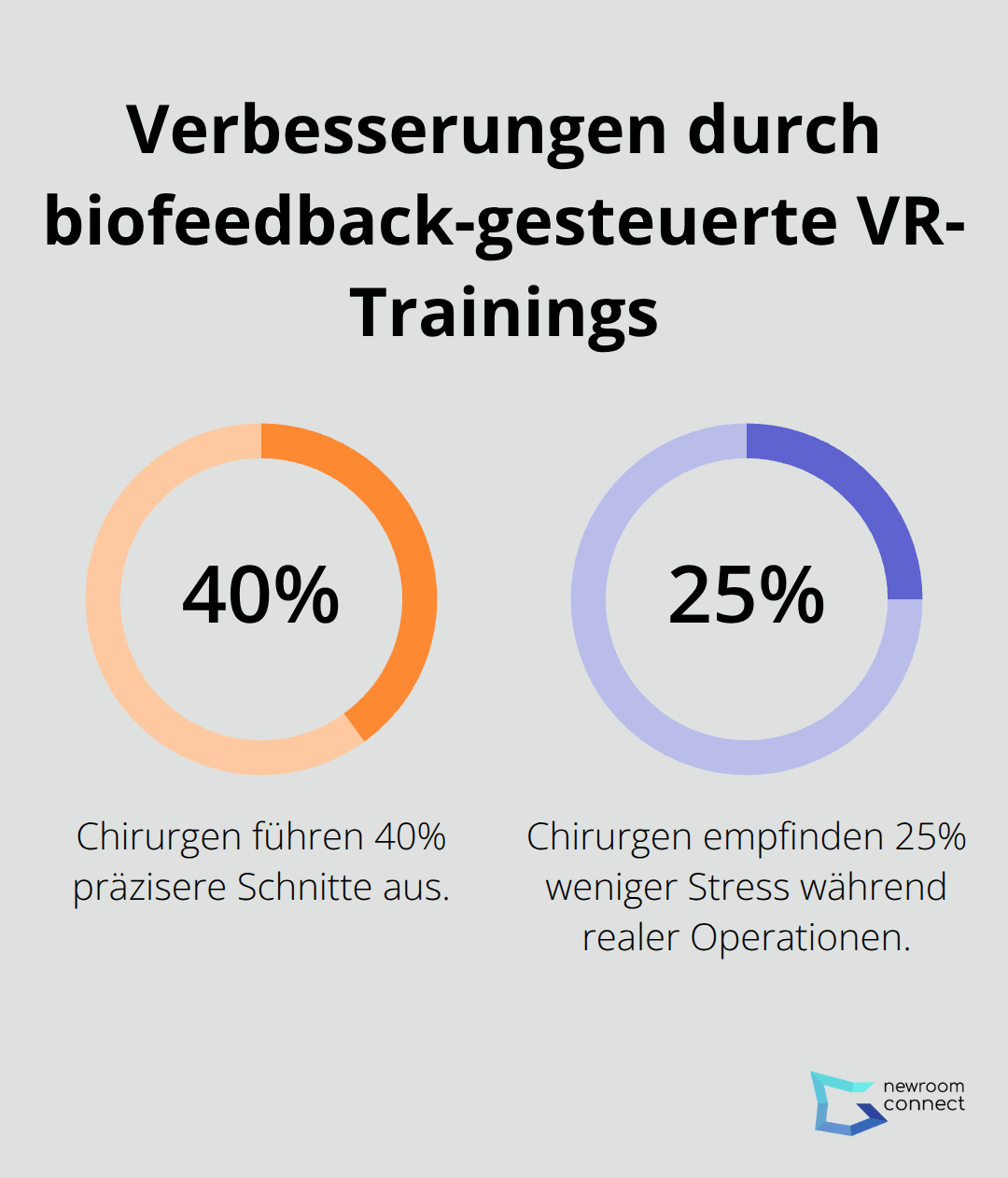

Eine Studie der Stanford Medical School belegt, dass Chirurgen nach biofeedback-gesteuerten VR-Trainings 40% präzisere Schnitte ausführen. Zusätzlich empfinden sie 25% weniger Stress während realer Operationen, da sie bereits in der virtuellen Umgebung gelernt haben, ihre physiologischen Reaktionen zu kontrollieren.

Personalisierte E-Learning-Plattformen

Deine Pupillenerweiterung verrät dem System binnen Sekunden, ob du dem Lernstoff folgen kannst oder bereits überfordert bist. Die Plattform Immersive VR Education analysiert Blickverhalten und Hautleitfähigkeit von Studenten während virtueller Geschichtslektionen. Bei Anzeichen kognitiver Überlastung wechselt das System zu einfacheren Darstellungen oder fügt interaktive Pausen ein (die das Verständnis fördern).

Universitäten berichten von 60% besseren Prüfungsergebnissen, wenn Studenten mit Biofeedback-gesteuerten VR-Lernumgebungen arbeiten. Diese adaptiven Systeme erkennen individuelle Lerngeschwindigkeiten und passen Inhalte entsprechend an.

Immersive Showrooms mit emotionaler Anpassung

Dein Herzschlag beschleunigt sich unbewusst, sobald du das perfekte Produkt siehst – und der virtuelle Showroom registriert diese Reaktion sofort. BMW nutzt in seinen VR-Showrooms Pulsmesser und Schweißsensoren, um emotionale Reaktionen auf verschiedene Automodelle zu messen. Steigt die Erregung bei bestimmten Fahrzeugkonfigurationen, hebt das System diese Optionen visuell hervor und bietet passende Finanzierungsmodelle an.

Händler verzeichnen 35% höhere Conversion-Raten durch biofeedback-gesteuerte VR-Präsentationen (verglichen mit statischen Katalogen). Diese emotionale Personalisierung erfordert jedoch präzise technische Umsetzung und spezialisierte Hardware, die individuelle biologische Merkmale präzise erfassen können.

Welche Hardware macht physiologische VR-Personalisierung möglich

Spezialisierte Sensoren für präzise Körperdatenerfassung

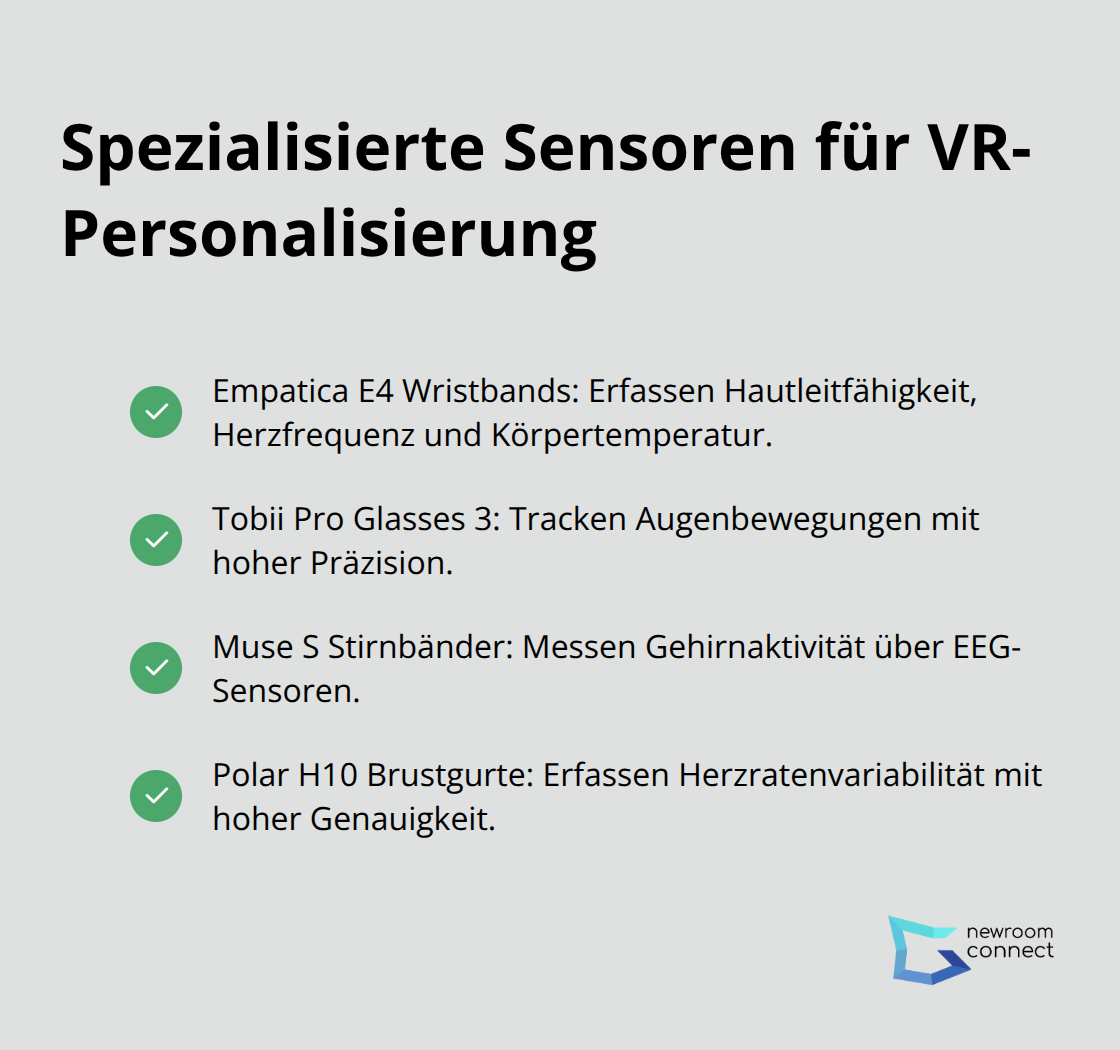

Empatica E4 Wristbands erfassen deine Hautleitfähigkeit mit einer Abtastrate von 4 Hz und messen gleichzeitig Herzfrequenz sowie Körpertemperatur. Diese medizinisch zertifizierten Geräte kosten etwa 1.700 Euro pro Einheit und liefern Daten mit einer Latenz unter 100 Millisekunden (was Echtzeit-Anpassungen ermöglicht). Tobii Pro Glasses 3 tracken deine Augenbewegungen mit 50 Hz Präzision und erfassen Pupillendurchmesser sowie Blickrichtung für 24.000 Euro pro System.

Muse S Stirnbänder messen deine Gehirnaktivität über vier EEG-Sensoren und erkennen Entspannung oder Konzentration binnen drei Sekunden. Diese Consumer-Geräte für 350 Euro integrieren sich nahtlos in Unity und Unreal Engine Projekte. Polar H10 Brustgurte erfassen deine Herzratenvariabilität mit 1000 Hz Genauigkeit und übertragen Daten drahtlos an VR-Headsets (ohne störende Kabel).

Machine Learning Algorithmen für Echtzeit-Datenauswertung

TensorFlow und PyTorch Bibliotheken analysieren deine physiologischen Muster durch neuronale Netzwerke, die aus Millionen von Datenpunkten lernen. Diese Algorithmen erkennen individuelle Stresssignaturen mit 92% Genauigkeit und passen virtuelle Inhalte binnen 50 Millisekunden an deine Bedürfnisse an. OpenBCI Cyton Boards verarbeiten acht EEG-Kanäle gleichzeitig und nutzen maschinelles Lernen zur Klassifikation emotionaler Zustände.

LSTM-Netzwerke predicten deine physiologischen Reaktionen 30 Sekunden im Voraus basierend auf bisherigen Mustern. Diese Vorhersagekraft ermöglicht proaktive Anpassungen der VR-Umgebung, bevor Stress oder Langeweile einsetzen (was das Nutzererlebnis erheblich verbessert).

Entwicklungsplattformen für adaptive VR-Erlebnisse

Unity XR Toolkit bietet vorgefertigte Komponenten zur Integration von Biofeedback-Daten in VR-Anwendungen. Entwickler nutzen das Toolkit zur Erstellung adaptiver Szenarien, die auf Herzfrequenz und Hautleitfähigkeit reagieren. Unreal Engine 5 Blueprint-System ermöglicht visuelles Programmieren von Biofeedback-Logik ohne komplexe Coding-Kenntnisse.

LabStreamingLayer synchronisiert Datenströme von bis zu 16 verschiedenen Biosensoren gleichzeitig und stellt diese Informationen VR-Engines zur Verfügung. Diese Open-Source-Plattform reduziert Entwicklungszeiten um 70% durch standardisierte Datenprotokolle und vereinfacht die Integration verschiedener Sensorsysteme erheblich.

Schlussfolgerung

Physiologische Daten verwandeln virtuelle Erlebnisse von statischen Präsentationen in dynamische, adaptive Umgebungen. Deine Herzfrequenz, Augenbewegungen und Hautleitfähigkeit werden zu präzisen Steuerungsinstrumenten, die VR-Inhalte in Echtzeit an deine Bedürfnisse anpassen. Diese Bio-Feedback Events steigern das Nutzerengagement um bis zu 60% und schaffen personalisierte Lernerfahrungen, die weit über traditionelle Methoden hinausgehen.

Die Implementierung bringt jedoch komplexe Herausforderungen mit sich. Sensible biometrische Daten erfordern höchste Datenschutzstandards und transparente Einverständniserklärungen. Zusätzlich benötigen Unternehmen spezialisierte Hardware für 1.700 bis 24.000 Euro pro System sowie Machine Learning Expertise für die Datenauswertung (was erhebliche Investitionen voraussetzt).

Die Zukunft physiologisch-personalisierter VR wird durch KI-Algorithmen geprägt, die deine Reaktionen 30 Sekunden im Voraus vorhersagen können. Diese adaptiven Technologien revolutionieren bereits heute immersive Showrooms und E-Learning-Plattformen, die auf individuelle Nutzerbedürfnisse reagieren. Newroom connect entwickelt innovative Lösungen für personalisierte virtuelle Erlebnisse, die nachhaltig bessere Lernergebnisse erzielen.