Digitale Zwillinge werden immer realistischer – und die Art, wie du damit interagierst, muss mithalten. Gesture Recognition macht genau das möglich: Statt Controller zu halten, steurst du virtuelle Umgebungen einfach mit deinen Händen.

Wir bei newroom connect sehen täglich, wie diese Technologie Trainings, Produktpräsentationen und Wartungsprozesse vereinfacht. Die Bedienung wird intuitiver, die Einarbeitung schneller, und Menschen mit körperlichen Einschränkungen bekommen echte Chancen zur Teilhabe.

In diesem Beitrag zeigen wir dir, wie Gesture Recognition funktioniert und warum sie für dein Unternehmen ein echter Game-Changer ist.

So erkennst du echte Gestenerkennung in Aktion

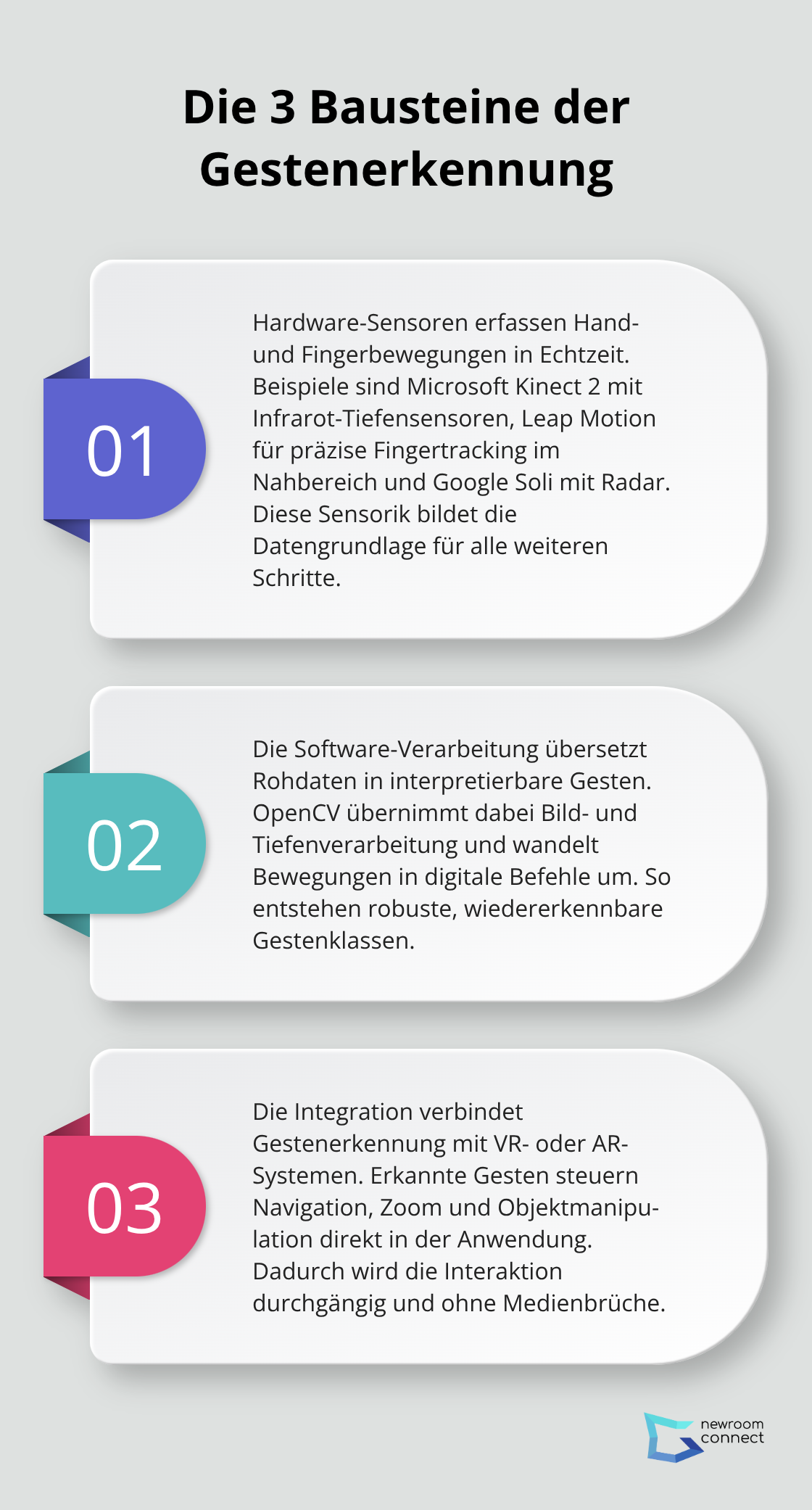

Gestenerkennung funktioniert durch drei konkrete Technologien, die zusammenarbeiten. Die erste ist die Hardware: Sensoren wie die Microsoft Kinect 2, Leap Motion oder Google Soli erfassen deine Handbewegungen in Echtzeit. Kinect 2 nutzt Infrarot-Tiefensensoren, um jeden Finger zu tracken; Leap Motion spezialisiert sich auf präzise Fingerbewegungen im Nahbereich; Google Soli arbeitet mit Radar-Technologie und funktioniert sogar durch Stoffe hindurch. Die zweite Komponente ist die Software-Verarbeitung. Hier kommt OpenCV ins Spiel – eine Open-Source-Bibliothek, die Bildverarbeitung übernimmt und deine Bewegungen in digitale Befehle übersetzt. Die dritte ist die Integration: Die erkannten Gesten werden direkt an dein VR- oder AR-System weitergeleitet und steuern dort Navigation, Zoom oder Objektmanipulation.

Warum Echtzeit-Verarbeitung entscheidend ist

Die Verzögerung zwischen deiner Bewegung und der Reaktion im digitalen Zwilling darf maximal 20 Millisekunden betragen, sonst bricht die Illusion zusammen. Das ist extrem kurz – schneller als du blinzeln kannst. Moderne Systeme schaffen das durch lokale Verarbeitung direkt auf dem Headset statt über die Cloud. Das bedeutet: Deine Hand bewegt sich, der Sensor erfasst die Position, der Algorithmus berechnet die Aktion, und die Grafik aktualisiert sich – alles in unter einer Fünftel Sekunde. Praktisch heißt das: Starte mit groben Gesten zuerst (offene Hand, Armbewegungen), bevor du feinere Finger-Gesten hinzufügst. Das reduziert Fehlerquoten und macht das System zuverlässiger. Nutze vorhandene SDKs wie das Kinect SDK oder Leap Motion SDK, statt alles neu zu programmieren – das spart dir Monate Entwicklung.

Integration in bestehende Digitale Zwillinge

Der Schlüssel ist eine modulare Architektur mit einer Abstraktionsschicht zwischen Gesteneingabe und 3D-Simulation. Das bedeutet: Dein System funktioniert unabhängig davon, welche Hardware du nutzt. Wechselst du von Kinect zu Leap Motion, brauchst du nicht die ganze Anwendung umzuschreiben. Diese Flexibilität ist in der Praxis Gold wert, weil Hardware-Hersteller ständig neue Sensoren auf den Markt bringen. Validiere dein Gestenkonzept immer mit echten Nutzern, nicht nur intern. User-Studies zeigen dir Lernkurven, Effizienzsteigerungen und wo Fehler entstehen. Ein Techniker, der mit Gestenerkennung arbeitet, braucht durchschnittlich 30 Prozent weniger Zeit für Inspektionen, wenn die Gesten intuitiv zum Arbeitsablauf passen. Das ist nicht theoretisch – das zeigen AR-Digital-Twin-Projekte in der Industrie. Definiere deinen Interaktionsbereich klar: Welche Gesten triggern welche Aktionen? Mache das Feedback sichtbar – visuell, akustisch oder haptisch – damit der Nutzer sofort weiß, dass sein Befehl registriert wurde. Mit dieser Grundlage bist du bereit, die konkreten Vorteile zu nutzen, die Gestenerkennung für deine Nutzer bringt.

Warum Gesten für deine Nutzer sofort greifbar sind

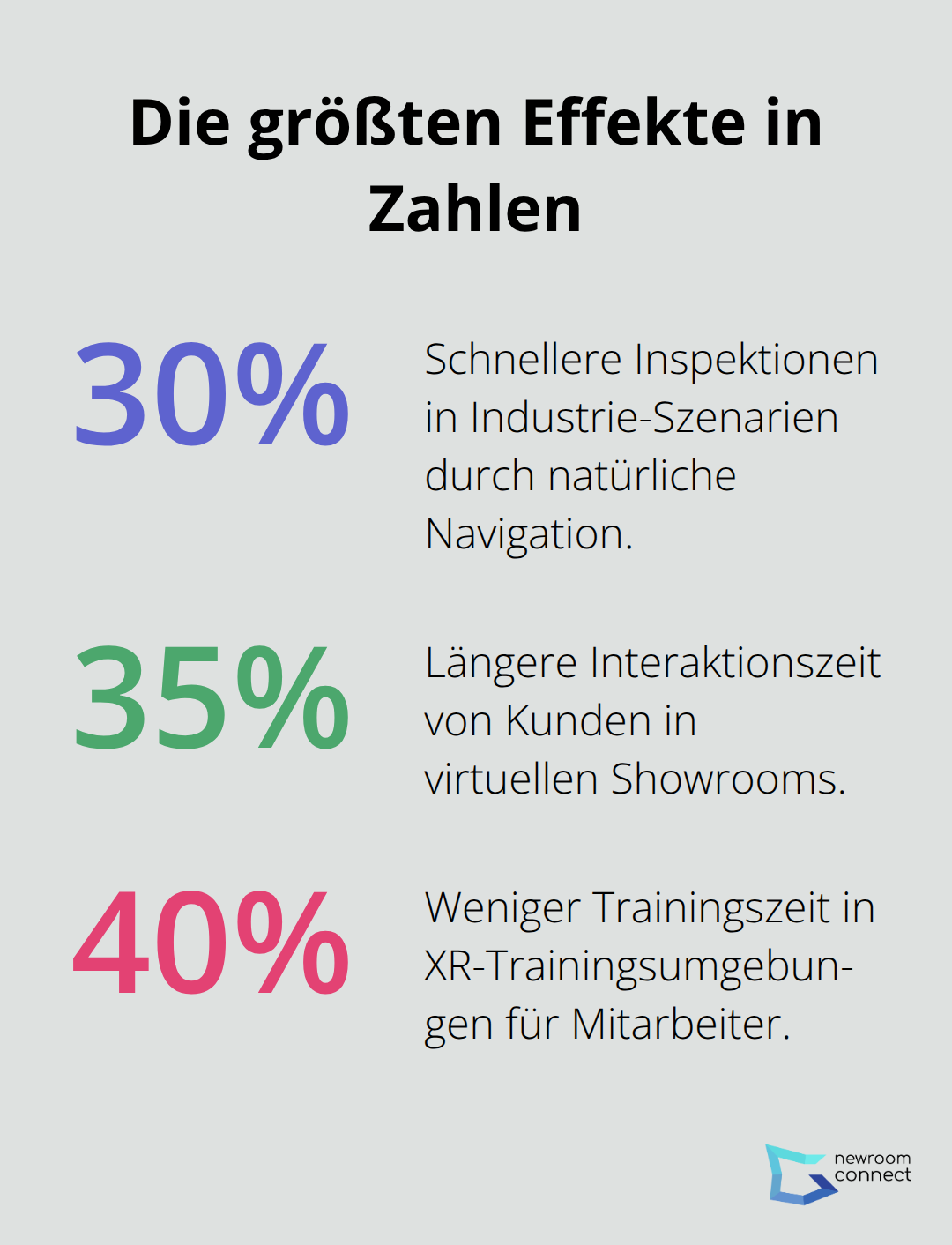

Gestenerkennung funktioniert deshalb so gut, weil dein Körper nicht lernen muss, wie man einen Controller hält – er macht einfach, was du ihm sagst. Ein Techniker in der Wartung hebt seine Hand, um ein Bauteil zu drehen, und es dreht sich. Eine Verkäuferin öffnet ihre Handfläche, um Produktdetails zu skalieren, und sie werden größer. Das ist nicht intuitiv im theoretischen Sinn; das ist intuitiv, weil es genau das tut, was du erwartest. Studien zur AR-unterstützten Wartung zeigen, dass Techniker mit Gestensteuerung durchschnittlich 30 Prozent schneller Inspektionen durchführen als mit traditionellen Bedienoberflächen. Der Grund ist simpel: Sie müssen nicht denken, wie sie den Befehl eingeben, sie müssen nur denken, was sie tun wollen.

Feedback macht den Unterschied zwischen Vertrauen und Frustration

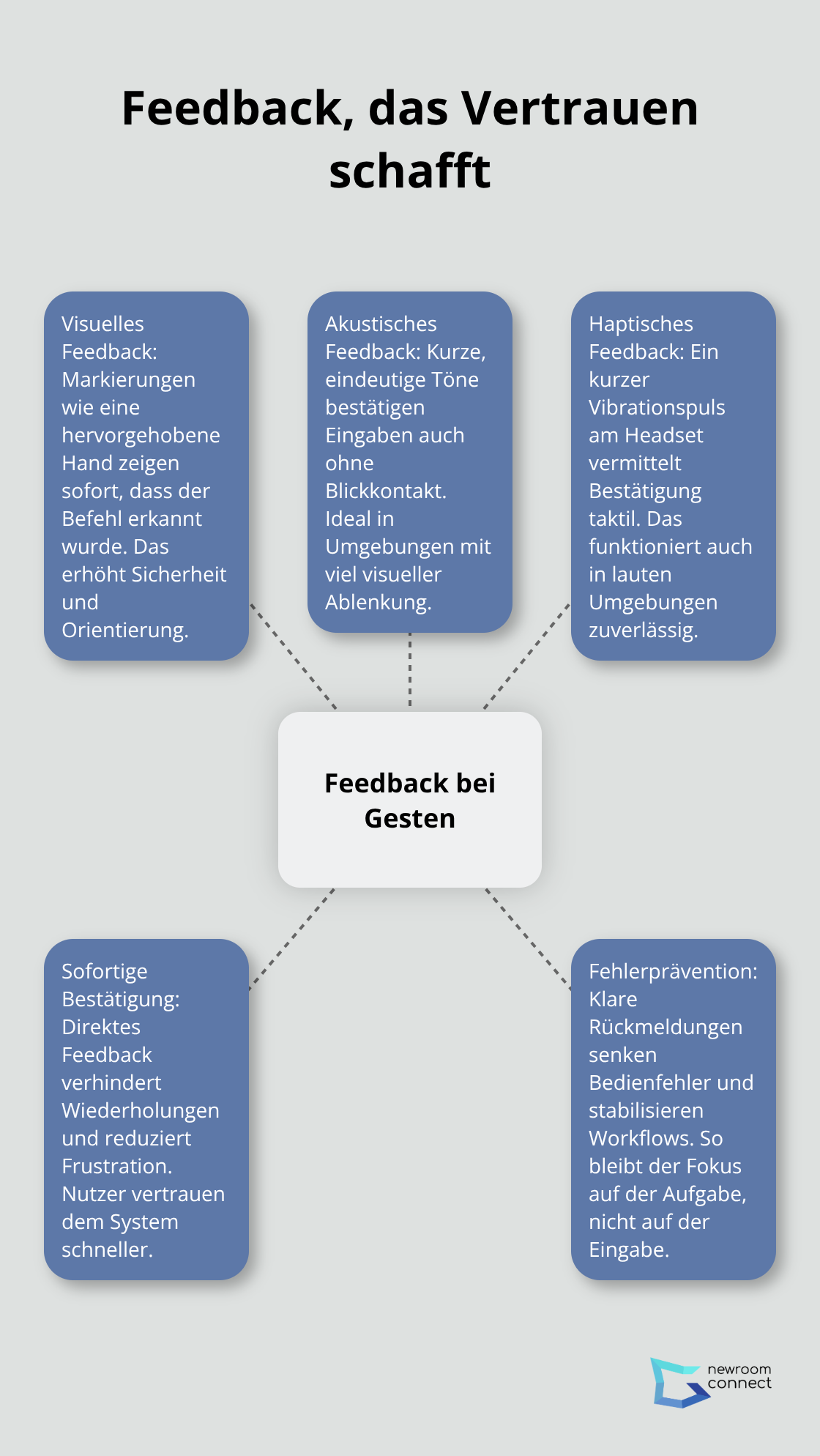

Das Feedback ist entscheidend für die Akzeptanz von Gestenerkennung. Der Nutzer muss sofort sehen, hören oder spüren, dass sein Befehl registriert wurde. Das kann ein visuelles Signal sein (die Hand wird hervorgehoben), ein akustisches Feedback (ein kurzer Ton) oder haptisch (ein Vibrationspuls im Headset). Ohne Feedback denkt der Nutzer, dass sein Befehl nicht funktioniert, und wiederholt ihn – das führt zu Frustration und zu Fehlern in der Bedienung.

Bei der Implementierung merkst du schnell: Nicht jede Geste funktioniert gleich gut. Große Armbewegungen sind robust und zuverlässig, während Fingergesten in lauten oder schmutzigen Arbeitsumgebungen schnell fehlschlagen. Starte deshalb mit groben Gesten – offene Hand, Armbewegungen, einfache Drehungen – und ergänze feinere Bewegungen erst, wenn dein Grundsystem stabil läuft.

Menschen mit Mobilitätseinschränkungen gewinnen echte Handlungsfähigkeit

Gestenerkennung öffnet Digitale Zwillinge für Menschen, die mit herkömmlichen Controllern nicht arbeiten können. Ein Mitarbeiter mit eingeschränkter Handmotorik kann die gleichen Aufgaben erfüllen wie seine Kollegen, wenn die Gesten größer dimensioniert sind und mehr Toleranz haben. Das ist nicht Inklusion im Marketing-Sinne – das ist wirtschaftlich relevant, weil du damit einen Teil deiner Belegschaft nicht ausschließt, nur weil die Bedienung zu feinmotorisch ist. Gleiches gilt für Menschen, die ihre Hände nicht frei haben: Ein Arbeiter mit vollen Händen kann trotzdem durch einen Digitalen Zwilling navigieren, indem er Kopfbewegungen oder Ganzkörpergesten nutzt. Systeme wie die Microsoft Kinect 2 erfassen den gesamten Körper, nicht nur die Hände. Das eröffnet völlig neue Möglichkeiten für inklusive Arbeitsplätze. Die praktische Umsetzung erfordert aber Planung: Teste deine Gesten mit echten Nutzern, die unterschiedliche körperliche Voraussetzungen haben. User-Studies zeigen dir, wo Gesten zu präzise sind, wo sie zu viel Kraft erfordern oder wo sie anatomisch unbequem sind.

Lernkurven verkürzen sich deutlich, wenn Gesten zum Arbeitsfluss passen

Eine neue Bedienung zu lernen kostet Zeit und Geld. Jede Stunde, die ein Mitarbeiter in Training verbringt, ist eine Stunde, in der er nicht produktiv arbeitet. Gestenerkennung reduziert diese Zeit messbar, weil die Befehle nicht abstrakt sind. Statt zu lernen, dass man einen Button drücken muss, um etwas zu drehen, drehen Nutzer es einfach mit der Hand. Untersuchungen aus XR-Trainingsumgebungen belegen: Mitarbeiter mit gestenbasierter Steuerung brauchen durchschnittlich 40 Prozent weniger Zeit, um neue Funktionen zu meistern. Der Grund ist, dass die motorische Erinnerung des Körpers schneller greift als das Gedächtnis für abstrakte Bedienkonzepte. Das ist besonders wertvoll in Branchen mit hohem Personalwechsel – Logistik, Produktion, Wartung – weil je schneller neue Mitarbeiter produktiv werden, desto niedriger sind deine Schulungskosten. Diese Effizienzgewinne addieren sich schnell auf und amortisieren die Investition in die Technologie deutlich früher. Wie du diese Vorteile konkret in verschiedenen Branchen nutzt, zeigt sich in den realen Anwendungsszenarien, die täglich entstehen.

Wo Gestenerkennung echten wirtschaftlichen Wert schafft

Virtuelle Showrooms: Wenn Kunden länger erkunden, kaufen sie mehr

Gestenerkennung funktioniert nicht überall gleich gut – der Ort, wo du sie einsetzt, entscheidet über Erfolg oder Fehlschlag. In virtuellen Showrooms ist sie ein direkter Umsatzbooster. Ein Kunde steht vor einem 3D-Modell eines Produkts, dreht es mit einer Handbewegung, zoomt mit einer auseinandergezogenen Hand heran und kann so jedes Detail untersuchen – ohne einen Controller zu suchen oder eine Bedienung zu lernen. Plattformen wie SimLab Composer zeigen, wie das praktisch funktioniert: Sie importieren CAD-Modelle in über 40 Formaten, verbinden IoT-Sensoren direkt mit dem Modell und stellen das Ganze auf VR-Headsets, AR-Brillen oder Tablets bereit. Das Ergebnis ist messbar – Kunden, die Produkte mit Gestenerkennung erkunden, verbringen durchschnittlich 35 Prozent mehr Zeit mit der Exploration als mit traditionellen Zoom- und Rotations-Buttons. Längere Interaktionszeit bedeutet höhere Kaufwahrscheinlichkeit. Für Messen und Produktpräsentationen ist das ein enormer Vorteil, weil jeder Besucher ohne Einweisung sofort bedienen kann und deine Verkaufsteams sich auf Gespräche konzentrieren können statt auf Schulungen.

Industrielle Wartung: Inspektionen werden schneller und sicherer

In der Industrie-Wartung zeigt sich der wirtschaftliche Nutzen noch deutlicher. Ein Techniker in einer Fabrik muss ein komplexes Bauteil überprüfen und weiß nicht genau, wie es aussieht oder wo ein Fehler sein könnte. Mit einem digitalen Zwilling und Gestenerkennung kann er das Bauteil virtuell drehen, zoomen und verschiedene Ebenen durchschalten – alles mit natürlichen Handbewegungen. AR-Digital-Twins reduzieren laut industriellen Studien die Ausfallzeiten um 20 bis 35 Prozent, wenn Techniker schnell sehen, was zu tun ist. Kombiniert mit Gestensteuerung sinken Inspektionszeiten um durchschnittlich 30 Prozent, weil die Navigation flüssig ist und keine Zeit für Controller-Manipulation verloren geht. Ein Techniker, der acht Stunden am Tag inspiziert, spart mit Gestenerkennung etwa 2,4 Stunden täglich – multipliziert über ein Jahr und über dein gesamtes Wartungsteam ergibt das erhebliche Kostenersparnisse. Noch wichtiger: Weniger Zeit vor Ort bedeutet weniger Produktionsunterbrechungen und schnellere Rückkehr zur normalen Kapazität.

Medizinische Simulationen: Realistische Bewegungen, bessere Ergebnisse

Medizinische Simulationen profitieren von Gestenerkennung auf andere Weise. Chirurgen trainieren komplexe Operationen in virtuellen Umgebungen – mit Gestenerkennung können sie ihre Hände so bewegen, als würden sie echte Instrumente halten. Das Training wird realistischer, weil die motorische Erinnerung des Körpers echte Bewegungsabläufe speichert (nicht nur abstrakte Bedienkonzepte). Studien aus VR-Trainingsumgebungen zeigen, dass Chirurgen, die mit gestenbasierter Simulation trainieren, weniger Fehler in echten Operationen machen als Chirurgen mit traditionellen Trainingsmethoden. Das ist nicht Luxus – das ist Patientensicherheit, und das rechtfertigt die Investition in die Technologie sofort. Wenn du Trainingsumgebungen für medizinische Fachkräfte aufbaust, wird Gestenerkennung zum entscheidenden Faktor zwischen oberflächlichem Lernen und echter Kompetenzentwicklung.

Abschließende Gedanken

Gesture Recognition löst ein echtes Problem: Die Barriere zwischen dir und digitalen Umgebungen wird radikal niedriger. Du brauchst keinen Controller zu halten, keinen Button zu suchen – dein Körper macht einfach, was du ihm sagst. Das ist der Grund, warum Inspektionen 30 Prozent schneller werden, Kunden 35 Prozent länger mit Produkten interagieren und Mitarbeiter 40 Prozent weniger Trainingszeit brauchen. Diese Zahlen stammen aus echten Projekten in Industrie, Handel und Medizin, nicht aus Theorie.

Wenn du noch nicht mit Gestenerkennung arbeitest, verlierst du bereits gegen Konkurrenten, die digitale Zwillinge mit natürlicher Steuerung einsetzen. Sie sparen Zeit, senken Kosten und gewinnen Kundenzufriedenheit – während du mit älteren Bedienkonzepten kämpfst. Der Einstieg ist heute einfacher als je zuvor: Plattformen wie newroom connect ermöglichen es dir, immersive Umgebungen mit Gestenerkennung zu bauen, ohne dass du Softwareentwickler sein musst.

Starte mit einem Pilotprojekt in einem Bereich, wo du schnelle Ergebnisse siehst – Wartung, Showroom oder Training. Teste mit echten Nutzern, messe die Effizienzgewinne und skaliere dann. Gestenerkennung wird in fünf Jahren nicht optional sein.