VR-Brillen zeigen dir heute noch längst nicht das, was dein Gehirn eigentlich sehen könnte. Die Visual Cortex Simulation ändert das grundlegend, indem sie nachbildet, wie dein visuelles Cortex Informationen verarbeitet.

Wir bei newroom connect sehen hier einen echten Wendepunkt: Trainings, medizinische Simulationen und virtuelle Ausstellungen werden dadurch deutlich realistischer. Die Technologie macht VR-Erfahrungen authentischer, weil sie die Art kopiert, wie dein Gehirn tatsächlich sieht.

Wie Visual Cortex Simulation funktioniert

Neuronale Verarbeitung visueller Informationen nachbilden

Dein Gehirn verarbeitet visuelle Informationen nicht wie eine Kamera. Der visuelle Cortex filtert, interpretiert und rekonstruiert ständig das, was du siehst. Visual Cortex Simulation nutzt genau diesen Prozess: Sie simuliert, wie dein Cortex Bewegungen erkennt, Tiefenunterschiede berechnet und deinen Blick automatisch lenkt. Das bedeutet konkret, dass VR-Systeme nicht mehr nur Bilder zeigen, sondern nachbilden, wie dein Gehirn diese Informationen tatsächlich verarbeitet.

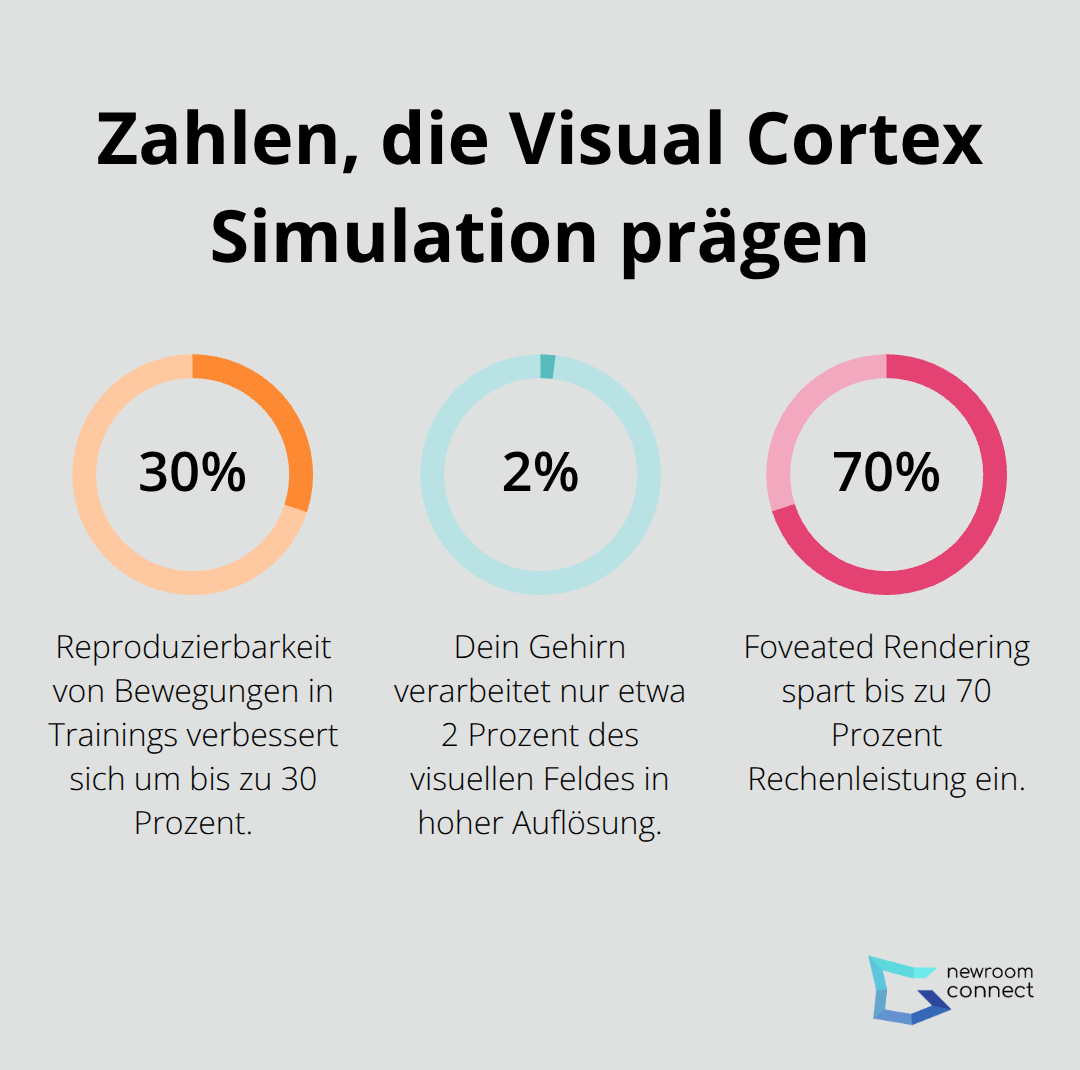

Der motorische Cortex wird bei der Visualisierung von Bewegungen aktiv. Diese mentale Simulation verbessert die Reproduzierbarkeit von Bewegungen um bis zu 30 Prozent – ein entscheidender Vorteil für Trainings. Wenn dein Gehirn in VR genauso reagiert wie in der Realität, speichert es Bewegungsabläufe präziser ab. Der Hippocampus speichert dabei räumliche Referenzen, was bedeutet, dass du dich in virtuellen Umgebungen konsistenter zurechtfindest.

Das macht besonders medizinische Simulationen und Flugsimulationen realistischer, weil dein Körper die Bewegungssequenzen wie in echten Situationen abspeichert.

Bewegungswahrnehmung und Tiefenerkennung optimieren

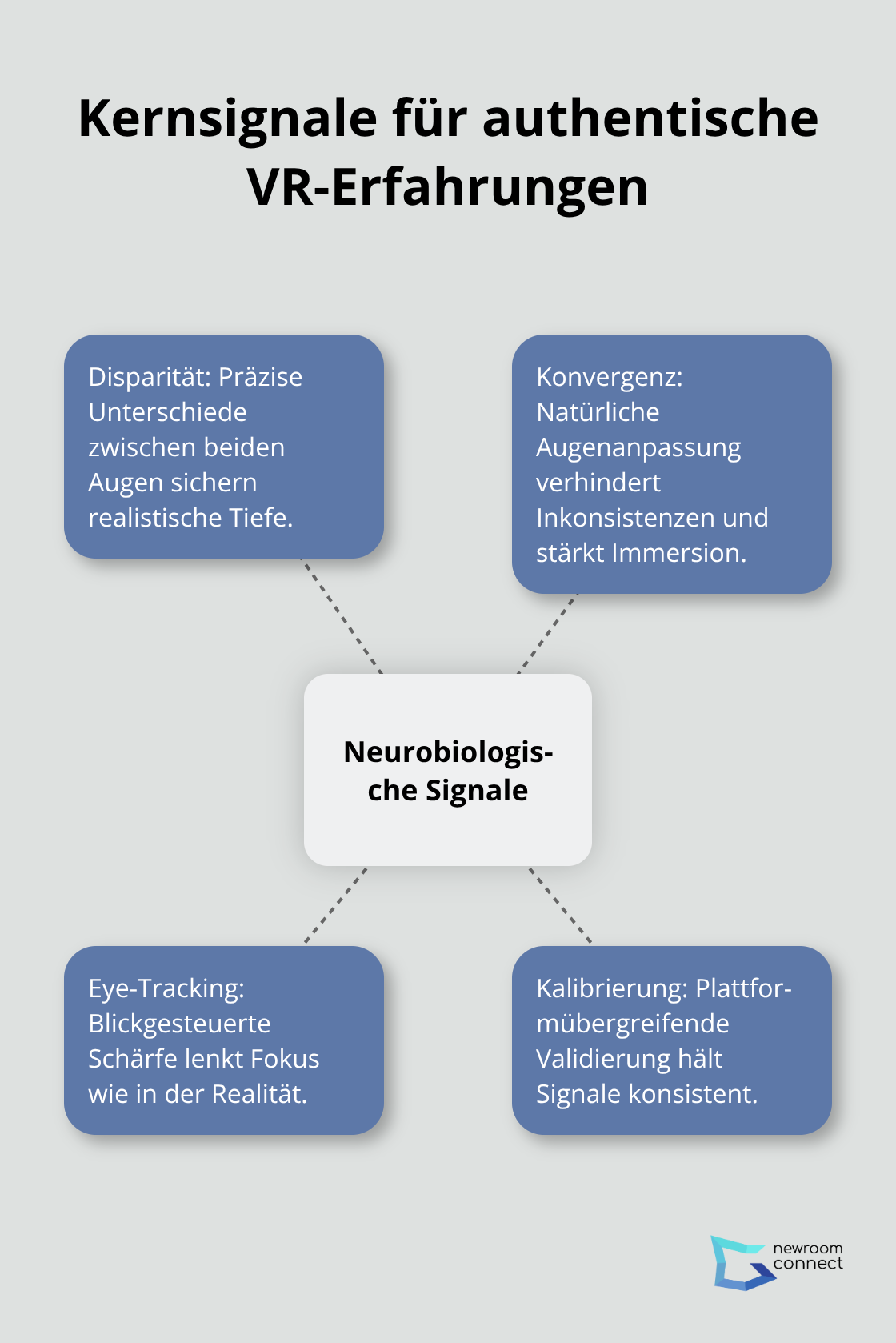

Dein visueller Cortex reagiert auf Bewegungen stärker als auf statische Bilder. Visual Cortex Simulation verstärkt genau diese Reaktion durch optimierte Bewegungsdarstellungen. Gleichzeitig wird die Tiefenwahrnehmung durch realistische Disparität und Konvergenz verbessert – deine Augen fokussieren in VR genauso wie in der realen Welt.

Die praktische Umsetzung funktioniert durch mehrere Mechanismen gleichzeitig. Dein visueller Cortex reagiert intensiver auf dynamische Szenen, während die Tiefenwahrnehmung durch präzise Disparitätsberechnung (der Unterschied zwischen dem, was jedes Auge sieht) und natürliche Konvergenz (wie deine Augen sich zusammenziehen) optimiert wird. Diese Kombination erzeugt eine Wahrnehmung, die der Realität deutlich näher kommt als herkömmliche VR-Darstellungen.

Augenbewegungen und Fokus realistisch darstellen

Augenbewegungen und Blickfokus werden durch Eye-Tracking erfasst und direkt in die Szene integriert. Dein Blick steuert, was scharf und was unscharf ist, genau wie in der Realität. Die Amygdala moduliert dabei deine emotionale Reaktion auf das, was du siehst – je realistischer dein Gehirn die Szene wahrnimmt, desto stärker sind deine emotionalen Reaktionen und desto besser merkst du dir die Inhalte.

Für VR-Anwendungen heißt das konkret, dass Trainings mit Visual Cortex Simulation zu besseren Lerneffekten führen, weil dein Gehirn die Situation als real einstuft und entsprechend speichert. Diese neurobiologische Grundlage macht den Unterschied zwischen oberflächlichem Sehen und echtem Verstehen aus. Genau diese Tiefe der Verarbeitung ist es, die immersive Trainings- und Schulungsprogramme so wirksam macht.

Wo Visual Cortex Simulation den größten Unterschied macht

Trainings mit messbarem Lerneffekt

Trainings in Unternehmen zeigen bereits heute, dass Realismus zu besseren Ergebnissen führt. Wenn dein Gehirn eine VR-Szene als authentisch einstuft, merkst du dir Inhalte deutlich besser – das liegt an der Art, wie dein motorischer Cortex Bewegungsabläufe speichert. Ein Flugtechniker, der eine Wartungssequenz mit realistischem Eye-Tracking und Tiefenwahrnehmung trainiert, führt diese später mit weniger Fehlern durch als mit klassischen Videos oder Text-Anleitungen. Der Grund liegt in der neurobiologischen Tiefe: Dein Cortex verarbeitet die Szene nicht als Animation, sondern als echte Situation.

Bei medizinischen Simulationen wird dieser Effekt noch deutlicher. Chirurgen, die komplexe Eingriffe mit realitätsgetreuem Blickfokus und präziser Tiefenwahrnehmung trainieren, zeigen signifikant bessere Handgriffe im OP. Dein Hippocampus speichert dabei nicht nur die Bewegung, sondern auch den räumlichen Kontext – wo jedes Instrument liegt, wie die Anatomie angeordnet ist. Diese räumliche Konsistenz ist in herkömmlichen VR-Trainings oft schwach, weil Bewegungen und Perspektivenwechsel nicht wie in der Realität verarbeitet werden.

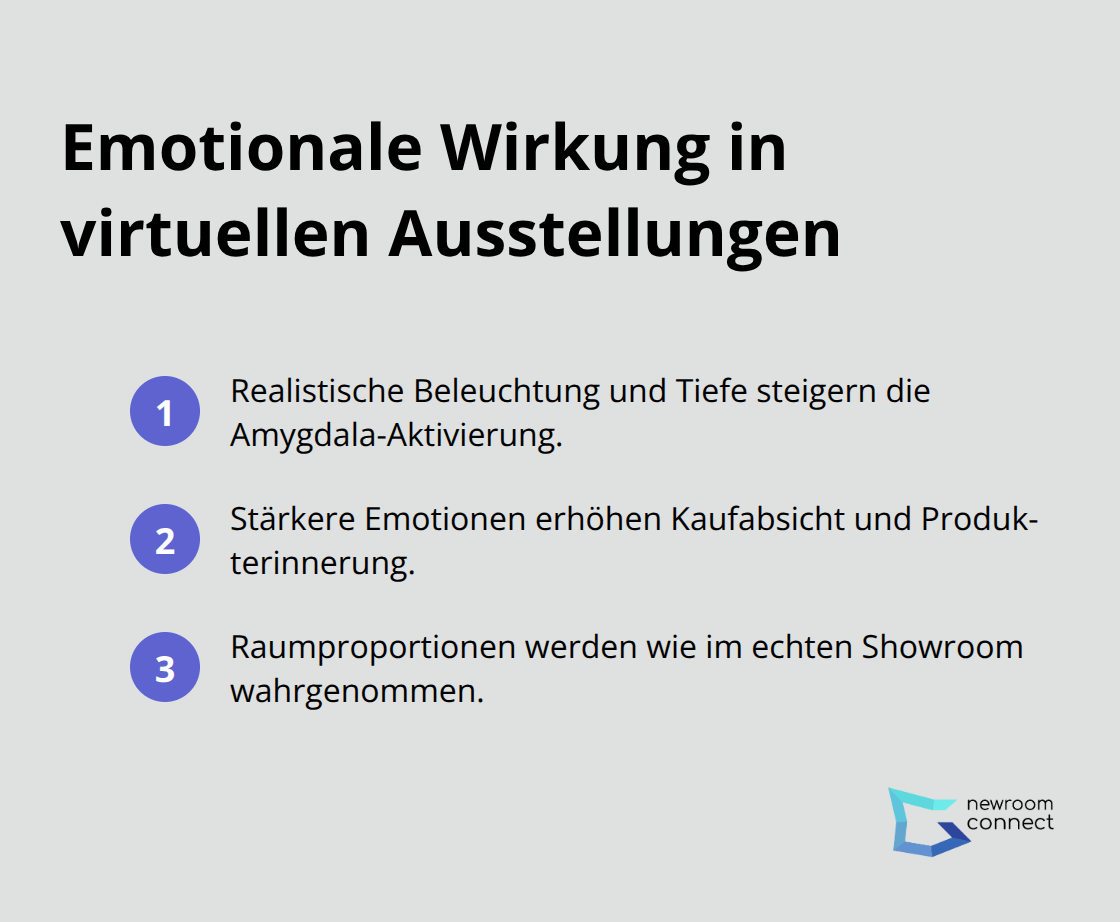

Emotionale Reaktionen in virtuellen Ausstellungen

Virtuelle Ausstellungen und Showrooms profitieren anders, aber genauso wirksam von Visual Cortex Simulation. Wenn dein Gehirn ein Produkt in einer virtuellen Umgebung mit realistischer Beleuchtung, Tiefenwahrnehmung und natürlichem Blickfokus sieht, aktiviert sich deine Amygdala intensiver – deine emotionale Reaktion ist stärker. Das führt zu höheren Kaufabsichten und besserer Erinnerung an Produkte.

Ein Möbelhersteller kann seine Kollektion in einer Visual Cortex Simulation zeigen und Kunden weltweit rund um die Uhr erreichen, während Raumproportionen so dargestellt werden, dass dein Gehirn sie genauso wahrnimmt wie in einem echten Showroom.

Die Kombination aus realistischer Grafik und neurobiologisch optimierter Wahrnehmung macht hier den entscheidenden Unterschied. Dein Cortex verarbeitet die Szene als echte Situation, nicht als Animation – und genau das führt zu stärkeren emotionalen Reaktionen und besserer Produkterinnerung.

Verhaltensänderung durch realistische Szenarien

E-Learning-Szenarien funktionieren nach dem gleichen Prinzip. Ein Sicherheitstraining mit realistischen Tiefensignalen und authentischer Bewegungsdarstellung führt zu besserer Verhaltensänderung als flache 2D-Kurse. Wenn dein Gehirn die Szene als echte Situation einstuft, speichert es nicht nur Fakten, sondern auch emotionale und motorische Reaktionen ab. Das macht dein Handeln im Ernstfall sicherer, weil dein Körper die Bewegungssequenzen bereits trainiert hat. Diese neurobiologische Grundlage erklärt, warum immersive Trainings mit Visual Cortex Simulation deutlich wirksamer sind als traditionelle Lernmethoden – dein Gehirn unterscheidet nicht zwischen Simulation und Realität, wenn die visuellen Signale authentisch genug sind.

Technische Herausforderungen und Lösungsansätze

Rechenleistung intelligent einsetzen, nicht verschwenden

Visual Cortex Simulation klingt nach einer Rechenmonster-Aufgabe – ist es aber nicht. Die größte Herausforderung liegt nicht in der Raw-Power, sondern in der intelligenten Optimierung. Moderne GPUs wie die NVIDIA RTX 4090 und die kommende NVIDIA Blackwell schaffen bereits Echtzeit-Rendering mit neurobiologisch optimierten Tiefensignalen bei 90 fps – das ist die Mindestanforderung für VR ohne Cybersickness. Das Problem: Viele Entwickler werfen zu viel Rechenleistung auf das falsche Problem. Sie versuchen, jedes Pixel fotorealistisch zu rendern, obwohl dein Gehirn nur etwa 2 Prozent deines visuellen Feldes mit hoher Auflösung verarbeitet.

Foveated Rendering nutzt genau das aus – es rendert nur den Bereich scharf, auf den du blickst, und spart dadurch bis zu 70 Prozent Rechenleistung ein. Das ist nicht nur effizienter, es ist auch neurobiologisch korrekt, weil es genau das simuliert, was dein Cortex tatsächlich tut. Eine durchschnittliche Gaming-GPU von vor drei Jahren reicht aus, um Visual Cortex Simulation mit realistischem Eye-Tracking und Tiefenwahrnehmung zu laufen. Das Echtzeit-Rendering bei hoher visueller Qualität funktioniert also nicht durch brute Force, sondern durch intelligente Algorithmen, die verstehen, wie dein Gehirn tatsächlich sieht.

Plattformübergreifende Kompatibilität standardisieren

Die Kompatibilität mit vorhandener Hardware ist ebenfalls überraschend unkompliziert geworden. Der glTF 2.0-Standard, entwickelt von der Khronos Group, hat sich als universelles Format für 3D-Assets etabliert und funktioniert auf Meta Quest, PlayStation VR2, HTC Vive und Windows Mixed Reality identisch. Das bedeutet konkret: Du entwickelst deine Visual Cortex Simulation einmal und rollst sie auf allen großen Plattformen aus, ohne neu zu kodieren.

WebXR, der offene Standard für VR im Browser, ermöglicht sogar plattformunabhängiges Streaming – Nutzer können deine Simulation auf praktisch jedem Gerät mit aktueller GPU starten, ohne separate Apps zu installieren. Der kritische Punkt ist nicht die technische Kompatibilität, sondern die Konsistenz der neurobiologischen Signale: Disparität, Konvergenz und Eye-Tracking müssen auf jeder Plattform identisch funktionieren, sonst verliert dein Gehirn die Authentizität. Hier liegt der echte Aufwand – nicht in der Hardware-Abstraktion, sondern in der präzisen Kalibrierung dieser Wahrnehmungssignale pro Plattform (mit modernen VR-SDKs wie dem OpenXR-Framework ist das inzwischen standardisiert und erfordert nur noch Validierungstests statt kompletter Neuentwicklungen).

Neurobiologische Konsistenz über alle Geräte

Die größte technische Hürde liegt in der Validierung dieser Signale. Dein visueller Cortex reagiert auf minimale Unterschiede in der Disparitätsberechnung oder der Konvergenzgeschwindigkeit – wenn diese Werte zwischen Plattformen variieren, nimmt dein Gehirn die Inkonsistenz sofort wahr und die Immersion bricht zusammen. Deshalb braucht es nicht nur technische Kompatibilität, sondern auch neurobiologische Validierung auf jeder Plattform. Mit modernen Testing-Tools und standardisierten Kalibrierungsprotokollen ist das heute machbar, ohne dass du für jede Plattform eine komplett neue Implementierung brauchst.

Schlussfolgerung

Visual Cortex Simulation funktioniert heute bereits und liefert messbare Ergebnisse – dein Gehirn unterscheidet nicht zwischen einer neurobiologisch optimierten VR-Erfahrung und der Realität, wenn die visuellen Signale authentisch genug sind. Die notwendigen Technologien sind verfügbar: moderne GPUs, standardisierte 3D-Formate wie glTF 2.0 und Eye-Tracking-Hardware sind längst in aktuellen VR-Systemen eingebaut. Foveated Rendering spart Rechenleistung, während OpenXR-Standards die plattformübergreifende Kompatibilität sichern, sodass du heute mit Visual Cortex Simulation starten kannst, ohne auf neue Hardware zu warten.

Für Unternehmen, die immersive Erlebnisse schaffen möchten, liegt der nächste Schritt darin, diese Technologien intelligent einzusetzen. Plattformen wie newroom connect ermöglichen es dir, virtuelle Ausstellungen, Showrooms und E-Learning-Umgebungen mit neurobiologisch optimierter Wahrnehmung zu gestalten – ohne dass du selbst tief in die technischen Details einsteigen musst. Die Software nutzt Unreal Engine 5 und moderne VR-Standards, um genau diese Authentizität zu liefern, die dein Gehirn braucht.

Die Zukunft von VR liegt nicht in noch besserer Grafik allein, sondern in der präzisen Simulation, wie dein visueller Cortex tatsächlich funktioniert. Unternehmen, die diesen Weg gehen, werden ihre Trainings wirksamer, ihre Showrooms überzeugender und ihre Lernprogramme erfolgreicher machen.