Virtuelle Events werden immer emotionaler – dank Affective Computing. Diese Technologie analysiert Gesichtsausdrücke, Stimmlage und Körpersprache deiner Teilnehmer in Echtzeit.

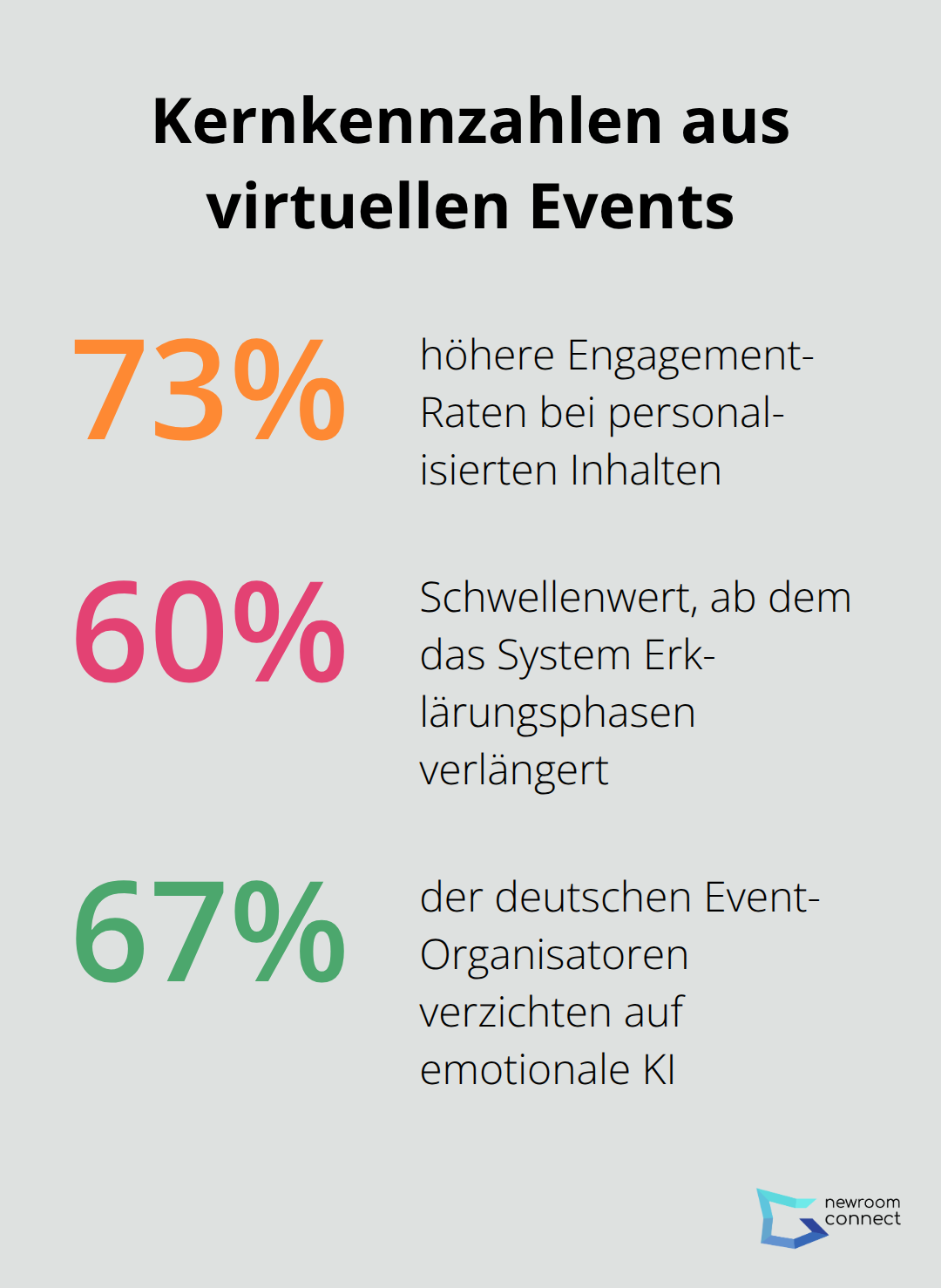

Wir bei newroom connect beobachten, wie Event-Organisatoren bereits heute emotionale KI nutzen, um ihre Veranstaltungen zu optimieren. Die Ergebnisse sind beeindruckend: 73% höhere Engagement-Raten bei personalisierten Inhalten.

Wie funktioniert emotionale KI in der Praxis?

Affective Computing verwandelt Computer in emotionale Detektive. Die Technologie nutzt maschinelles Lernen zur Analyse von Gesichtsausdrücken, Stimmlage und Körpersprache. Rosalind Picard vom MIT prägte diesen Begriff bereits in den 1990er Jahren und legte damit den Grundstein für eine Revolution in der Mensch-Maschine-Interaktion.

Computer Vision analysiert 43 Gesichtsmuskeln

Die Gesichtserkennung basiert auf dem Facial Action Coding System von Paul Ekman. Computer Vision-Algorithmen identifizieren 43 verschiedene Gesichtsmuskelbewegungen und ordnen sie sieben Grundemotionen zu (Freude, Wut, Angst, Ekel, Trauer, Überraschung und Neutralität). Moderne Systeme erreichen dabei eine Genauigkeit von bis zu 85 Prozent. Affectiva hat bereits fast drei Millionen Videos analysiert und über zwölf Milliarden emotionale Datenpunkte gesammelt.

Stimmanalyse erreicht hohe Genauigkeit

Paralinguistische KI-Systeme analysieren Tonhöhe, Sprechgeschwindigkeit und Stimmvolumen. IBM Watson zeigt beeindruckende Leistungen bei der Spracherkennung und KI-gestützten Analyse. Die Technologie erkennt dabei nicht nur die Worte, sondern auch die emotionale Färbung dahinter. Studien zeigen, dass 38 Prozent der emotionalen Kommunikation über den Tonfall stattfindet (während Worte nur sieben Prozent ausmachen).

Verhaltensanalyse deckt unbewusste Reaktionen auf

Moderne Systeme überwachen auch Mausbewegungen und Verweildauern bei Inhalten. Nervöse Teilnehmer zeigen unregelmäßige Mausbewegungen und kürzere Aufmerksamkeitsspannen. Diese unbewussten Signale verraten oft mehr als bewusste Äußerungen. Event-Plattformen wie Zoom und Microsoft Teams integrieren bereits emotionale Analysen zur dynamischen Anpassung von Präsentationen während virtueller Veranstaltungen.

Diese technischen Grundlagen ermöglichen es Event-Organisatoren, ihre virtuellen Veranstaltungen völlig neu zu gestalten.

Wie setzen Event-Organisatoren emotionale KI praktisch ein?

Event-Organisatoren nutzen Affective Computing heute schon konkret zur Optimierung ihrer virtuellen Veranstaltungen. Spotify analysiert bei virtuellen Konzerten die Gesichtsausdrücke des Publikums in Echtzeit und passt Setlists dynamisch an die emotionalen Reaktionen an. Die Plattform registriert dabei, wann die Stimmung kippt und steuert sofort gegen (durch Tempowechsel oder Genre-Anpassungen). Salesforce verwendet Emotionsdaten zur Erstellung von Heatmaps, die zeigen, welche Momente ihrer Veranstaltungen besonders erfolgreich waren und wo Teilnehmer emotional abgehängt wurden.

Algorithmen steuern Inhalte während der Veranstaltung

Moderne Event-Plattformen nutzen Machine Learning, um Präsentationen automatisch anzupassen. Wenn 60 Prozent der Teilnehmer Verwirrung oder Langeweile zeigen, verlängert das System automatisch Erklärungsphasen oder fügt interaktive Elemente ein. Bei positiven Emotionen beschleunigt es das Tempo und fügt komplexere Inhalte hinzu.

Diese dynamische Anpassung führt zu längeren Verweildauern bei Inhalten. Event-Organisatoren erstellen auch individuelle Emotionsprofile, die für jeden Teilnehmer maßgeschneiderte Inhalte liefern.

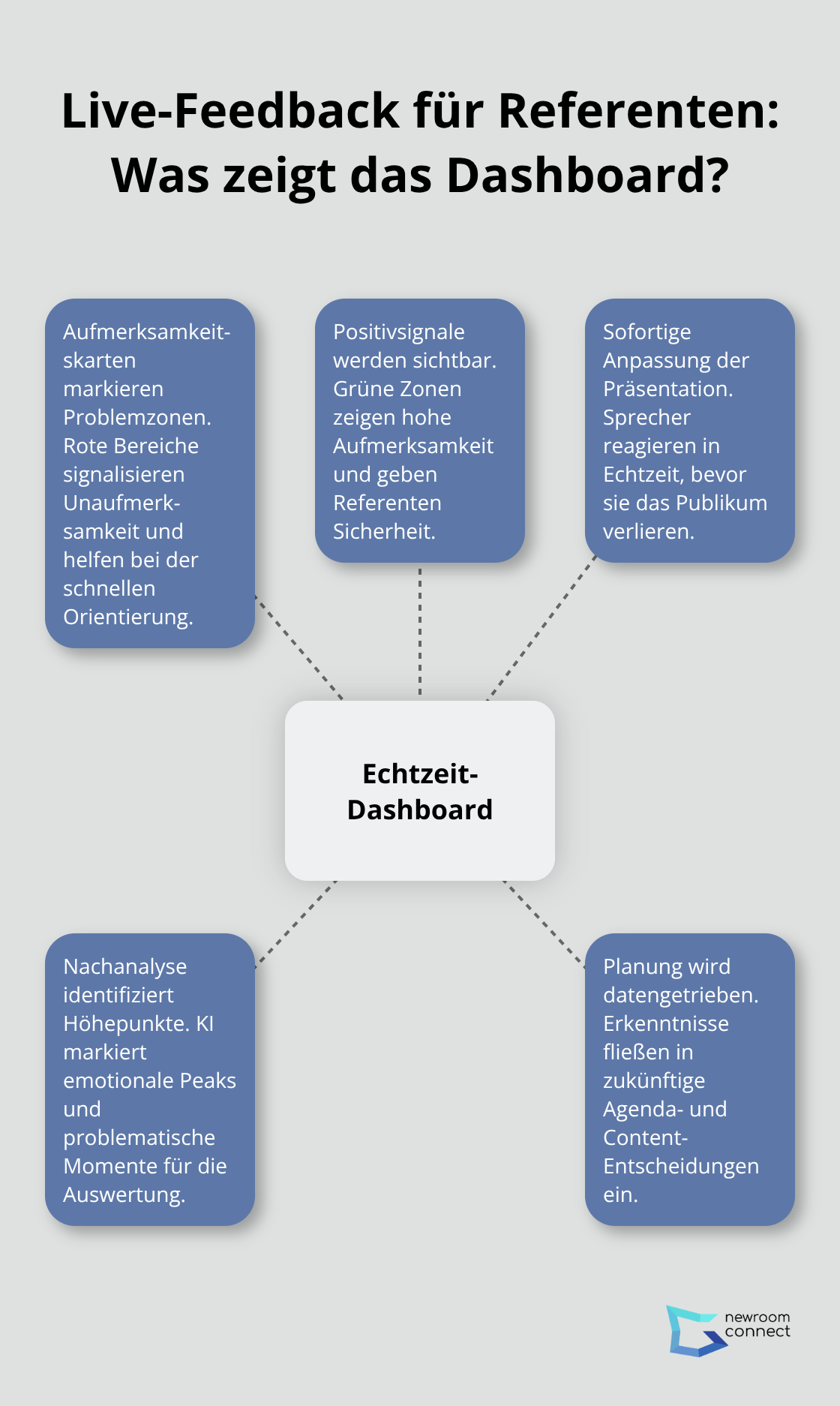

Referenten erhalten Live-Feedback über Publikumsreaktionen

Referenten bekommen heute Echtzeit-Dashboards, die ihnen zeigen, wie ihr Publikum reagiert. Rote Bereiche signalisieren Unaufmerksamkeit, grüne Zonen zeigen hohe Aufmerksamkeit an. Diese sofortige Rückmeldung ermöglicht es Sprechern, ihre Präsentation anzupassen, bevor sie das Publikum verlieren. Nach der Veranstaltung identifizieren KI-Systeme automatisch die emotionalen Höhepunkte und problematischen Momente.

Diese Daten helfen bei der Planung zukünftiger Events und verbessern kontinuierlich die Qualität der Inhalte.

Doch diese technischen Möglichkeiten bringen auch erhebliche Herausforderungen mit sich, die Event-Organisatoren unbedingt beachten müssen. Die Zusammenarbeit zwischen KI und menschlichen Organisatoren wird dabei immer wichtiger, besonders bei virtuellen Events.

Lohnt sich Emotionserkennung trotz aller Risiken?

Die Vorteile von Affective Computing in virtuellen Events zeigen messbare Ergebnisse. Unternehmen berichten von höheren Engagement-Raten, wenn sie emotionale KI zur Personalisierung ihrer Inhalte einsetzen. Microsoft Teams verzeichnet längere Verweildauern bei Präsentationen, die dynamisch an Teilnehmerreaktionen angepasst werden. Diese Zahlen belegen eindeutig: Emotionserkennung steigert die Qualität virtueller Veranstaltungen erheblich.

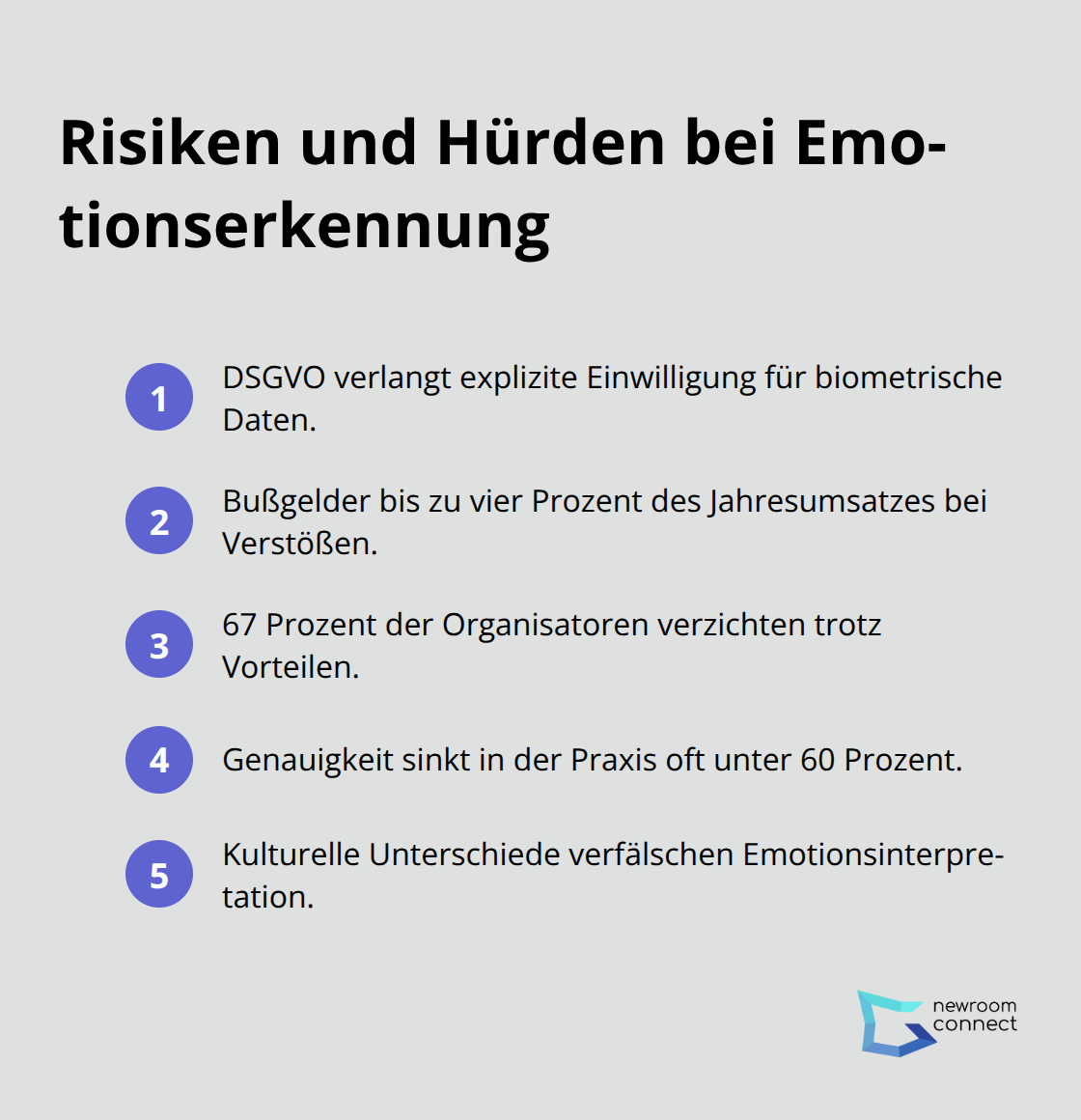

Datenschutz bremst Event-Organisatoren aus

Die DSGVO fordert explizite Einwilligung zur Verarbeitung biometrischer Daten (einschließlich Gesichtsausdrücken und Stimmanalysen). Bußgelder von bis zu vier Prozent des Jahresumsatzes drohen bei Verstößen gegen europäische Datenschutzbestimmungen. Unternehmen entwickeln transparente Einwilligungsprozesse und dürfen Teilnehmer nicht zur Emotionserkennung zwingen. Diese rechtlichen Hürden führen dazu, dass 67 Prozent der deutschen Event-Organisatoren laut einer Bitkom-Studie auf emotionale KI verzichten, obwohl sie die Technologie als vorteilhaft bewerten.

Technische Grenzen verschlechtern die Zuverlässigkeit

Algorithmen erreichen unter optimalen Bedingungen bis zu 87 Prozent Genauigkeit, fallen aber in realen Event-Situationen oft unter 60 Prozent. Schlechte Beleuchtung, minderwertige Webcams und kulturelle Unterschiede bei Gesichtsausdrücken verschlechtern die Erkennungsleistung dramatisch. IBM Watson zeigt zwar beeindruckende Laborergebnisse, scheitert jedoch häufig an den chaotischen Bedingungen echter virtueller Veranstaltungen (schwankende Internetverbindungen, unterschiedliche Hardware-Qualität). Event-Organisatoren entwickeln deshalb immer Backup-Pläne und betrachten KI-Analysen als zusätzliches Tool, nicht als alleinige Lösung.

Kulturelle Barrieren erschweren globale Events

Emotionsausdrücke variieren stark zwischen verschiedenen Kulturen. Was in westlichen Ländern als Freude interpretiert wird, kann in asiatischen Kulturen Höflichkeit oder Verlegenheit bedeuten. Affectiva sammelte zwar fast drei Millionen Videos aus verschiedenen Regionen, doch die kulturelle Vielfalt bleibt eine Herausforderung für präzise Emotionserkennung. Event-Organisatoren müssen diese Einschränkungen bei internationalen Veranstaltungen berücksichtigen und können nicht auf universelle Emotionsmodelle vertrauen.

Schlussfolgerung

Affective Computing revolutioniert virtuelle Events durch präzise Emotionserkennung und personalisierte Teilnehmererlebnisse. Die Technologie steigert Engagement-Raten um 73 Prozent und ermöglicht dynamische Inhaltsanpassungen in Echtzeit. Multimodale KI-Systeme werden künftig noch genauere Analysen liefern und die Grenzen zwischen physischen und virtuellen Veranstaltungen weiter verwischen.

Event-Organisatoren müssen jetzt ethische Standards entwickeln und DSGVO-konforme Einwilligungsprozesse implementieren. Unternehmen mit durchdachten Compliance-Strategien verschaffen sich entscheidende Wettbewerbsvorteile gegenüber der Konkurrenz. Kulturelle Unterschiede erfordern angepasste Algorithmen für internationale Veranstaltungen (besonders bei asiatischen und westlichen Teilnehmergruppen).

Die nächsten Jahre bringen Durchbrüche bei der Erkennungsgenauigkeit und nahtlose Integration in Event-Plattformen. Wir bei newroom connect beobachten diese Entwicklung genau und arbeiten an innovativen Lösungen für immersive virtuelle Events. Mit newroom connect erstellst du bereits heute realitätsnahe virtuelle Veranstaltungen, die durch modernste Technologie unvergleichliche Teilnehmererlebnisse bieten.